Revert all the changes since 851f9ec

@@ -1,127 +0,0 @@

|

||||

# OpenGL

|

||||

|

||||

原文 | [OpenGL](http://learnopengl.com/#!Getting-started/OpenGL)

|

||||

---|---

|

||||

作者 | JoeyDeVries

|

||||

翻译 | gjy_1992

|

||||

校对 | Geequlim

|

||||

|

||||

|

||||

在开始这段旅程之前我们先了解一下OpenGL到底是什么。一般它被认为是一个API(**Application Programming Interface**, 应用程序编程接口),包含了一系列可以操作图形、图像的函数。然而,OpenGL本身并不是一个API,它仅仅是一个由[Khronos组织](http://www.khronos.org/)制定并维护的规范(Specification)。

|

||||

|

||||

<img alt="OpenGL Logo" src="http://learnopengl.com/img/getting-started/opengl.jpg" align="right" />

|

||||

|

||||

OpenGL规范严格规定了每个函数该如何执行,以及它们的输出值。至于内部具体每个函数是如何实现(Implement)的,将由OpenGL库的开发者自行决定(注:这里开发者是指编写OpenGL库的人)。因为OpenGL规范并没有规定实现的细节,具体的OpenGL库允许使用不同的实现,只要其功能和结果与规范相匹配(亦即,作为用户不会感受到功能上的差异)。

|

||||

|

||||

实际的OpenGL库的开发者通常是显卡的生产商。你购买的显卡所支持的OpenGL版本都为这个系列的显卡专门开发的。当你使用Apple系统的时候,OpenGL库是由Apple自身维护的。在Linux下,有显卡生产商提供的OpenGL库,也有一些爱好者改编的版本。这也意味着任何时候OpenGL库表现的行为与规范规定的不一致时,基本都是库的开发者留下的bug。

|

||||

|

||||

!!! important

|

||||

|

||||

由于OpenGL的大多数实现都是由显卡厂商编写的,当产生一个bug时通常可以通过升级显卡驱动来解决。这些驱动会包括你的显卡能支持的最新版本的OpenGL,这也是为什么总是建议你偶尔更新一下显卡驱动。

|

||||

|

||||

所有版本的OpenGL规范文档都被公开的寄存在Khronos那里。有兴趣的读者可以找到OpenGL3.3(我们将要使用的版本)的[规范文档](https://www.opengl.org/registry/doc/glspec33.core.20100311.withchanges.pdf)。如果你想深入到OpenGL的细节(只关心函数功能的描述而不是函数的实现),这是个很好的选择。如果你想知道每个函数**具体的**运作方式,这个规范也是一个很棒的参考。

|

||||

|

||||

## 核心模式与立即渲染模式

|

||||

|

||||

早期的OpenGL使用**立即渲染模式**(Immediate mode,也就是**固定渲染管线**),这个模式下绘制图形很方便。OpenGL的大多数功能都被库隐藏起来,开发者很少能控制OpenGL如何进行计算的自由。而开发者迫切希望能有更多的灵活性。随着时间推移,规范越来越灵活,开发者对绘图细节有了更多的掌控。立即渲染模式确实容易使用和理解,但是效率太低。因此从OpenGL3.2开始,规范文档开始废弃立即渲染模式,推出核心模式(Core-profile),这个模式完全移除了旧的特性。

|

||||

|

||||

当使用OpenGL的核心模式时,OpenGL迫使我们使用现代的函数。当我们试图使用一个已废弃的函数时,OpenGL会抛出一个错误并终止绘图。现代函数的优势是更高的灵活性和效率,然而也更难于学习。立即渲染模式从OpenGL**实际**运作中抽象掉了很多细节,因而它易于学习的同时,也很难去把握OpenGL具体是如何运作的。现代函数要求使用者真正理解OpenGL和图形编程,它有一些难度,然而提供了更多的灵活性,更高的效率,更重要的是可以更深入的理解图形编程。

|

||||

|

||||

这也是为什么我们的教程面向OpenGL3.3的核心模式。虽然上手更困难,但这份努力是值得的。

|

||||

|

||||

现今,更高版本的OpenGL已经发布(写作时最新版本为4.5),你可能会问:既然OpenGL 4.5 都出来了,为什么我们还要学习OpenGL 3.3?答案很简单,所有OpenGL的更高的版本都是在3.3的基础上,引入了额外的功能,并没有改动核心架构。新版本只是引入了一些更有效率或更有用的方式去完成同样的功能。因此,所有的概念和技术在现代OpenGL版本里都保持一致。当你的经验足够,你可以轻松使用来自更高版本OpenGL的新特性。

|

||||

|

||||

!!! attention

|

||||

|

||||

当使用新版本的OpenGL特性时,只有新一代的显卡能够支持你的应用程序。这也是为什么大多数开发者基于较低版本的OpenGL编写程序,并只提供选项启用新版本的特性。

|

||||

|

||||

在有些教程里你会看见更现代的特性,它们同样会以这种红色注释方式标明。

|

||||

|

||||

## 扩展

|

||||

|

||||

OpenGL的一大特性就是对扩展(Extension)的支持,当一个显卡公司提出一个新特性或者渲染上的大优化,通常会以**扩展**的方式在驱动中实现。如果一个程序在支持这个扩展的显卡上运行,开发者可以使用这个扩展提供的一些更先进更有效的图形功能。通过这种方式,开发者不必等待一个新的OpenGL规范面世,就可以使用这些新的渲染特性了,只需要简单地检查一下显卡是否支持此扩展。通常,当一个扩展非常流行或者非常有用的时候,它将最终成为未来的OpenGL规范的一部分。

|

||||

|

||||

使用扩展的代码大多看上去如下:

|

||||

|

||||

```c++

|

||||

if(GL_ARB_extension_name)

|

||||

{

|

||||

// 使用一些新的特性

|

||||

}

|

||||

else

|

||||

{

|

||||

// 不支持此扩展: 用旧的方式去做

|

||||

}

|

||||

```

|

||||

|

||||

使用OpenGL3.3时,我们很少需要使用扩展来完成大多数功能,当需要的时候,本教程将提供适当的指示。

|

||||

|

||||

## 状态机

|

||||

|

||||

OpenGL自身是一个巨大的状态机(State Machine):一系列的变量描述OpenGL此刻应当如何运行。OpenGL的状态通常被称为OpenGL**上下文(Context)**。我们通常使用如下途径去更改OpenGL状态:设置选项,操作缓冲。最后,我们使用当前OpenGL上下文来渲染。

|

||||

|

||||

假设当我们想告诉OpenGL去画线段而不是三角形的时候,我们通过改变一些上下文变量来改变OpenGL状态,从而告诉OpenGL如何去绘图。一旦我们改变了OpenGL的状态为绘制线段,下一个绘制命令就会画出线段而不是三角形。

|

||||

|

||||

当使用OpenGL的时候,我们会遇到一些**状态设置**函数(State-changing Function),这类函数将会改变上下文。以及**状态应用**函数(State-using Function),这类函数会根据当前OpenGL的状态执行一些操作。只要你记住OpenGL本质上是个大状态机,就能更容易理解它的大部分特性。

|

||||

|

||||

## 对象

|

||||

|

||||

OpenGL库是用C语言写的,同时也支持多种语言的派生,但其内核仍是一个C库。由于C的一些语言结构不易被翻译到其它的高级语言,因此OpenGL开发的时候引入了一些抽象层。“对象(Object)”就是其中一个。

|

||||

|

||||

在OpenGL中一个**对象**是指一些选项的集合,它代表OpenGL状态的一个子集。比如,我们可以用一个对象来代表绘图窗口的设置,之后我们就可以设置它的大小、支持的颜色位数等等。可以把对象看做一个C风格的结构体(Struct):

|

||||

|

||||

```c++

|

||||

struct object_name {

|

||||

GLfloat option1;

|

||||

GLuint option2;

|

||||

GLchar[] name;

|

||||

};

|

||||

```

|

||||

|

||||

!!! important

|

||||

|

||||

**基元类型(Primitive Type)**

|

||||

|

||||

使用OpenGL时,建议使用OpenGL定义的基元类型。比如使用`float`时我们加上前缀`GL`(因此写作`GLfloat`)。`int`、`uint`、`char`、`bool`等等也类似。OpenGL定义的这些GL基元类型的内存布局是与平台无关的,而int等基元类型在不同操作系统上可能有不同的内存布局。使用GL基元类型可以保证你的程序在不同的平台上工作一致。

|

||||

|

||||

当我们使用一个对象时,通常看起来像如下一样(把OpenGL上下文看作一个大的结构体):

|

||||

|

||||

```c++

|

||||

// OpenGL的状态

|

||||

struct OpenGL_Context

|

||||

{

|

||||

...

|

||||

object* object_Window_Target;

|

||||

...

|

||||

};

|

||||

```

|

||||

|

||||

```c++

|

||||

// 创建对象

|

||||

GLuint objectId = 0;

|

||||

glGenObject(1, &objectId);

|

||||

// 绑定对象至上下文

|

||||

glBindObject(GL_WINDOW_TARGET, objectId);

|

||||

// 设置当前绑定到 GL_WINDOW_TARGET 的对象的一些选项

|

||||

glSetObjectOption(GL_WINDOW_TARGET, GL_OPTION_WINDOW_WIDTH, 800);

|

||||

glSetObjectOption(GL_WINDOW_TARGET, GL_OPTION_WINDOW_HEIGHT, 600);

|

||||

// 将上下文对象设回默认

|

||||

glBindObject(GL_WINDOW_TARGET, 0);

|

||||

```

|

||||

|

||||

这一小段代码展现了你以后使用OpenGL时常见的工作流。我们首先创建一个对象,然后用一个id保存它的引用(实际数据被储存在后台)。然后我们将对象绑定至上下文的目标位置(例子中窗口对象目标的位置被定义成`GL_WINDOW_TARGET`)。接下来我们设置窗口的选项。最后我们将目标位置的对象id设回0,解绑这个对象。设置的选项将被保存在`objectId`所引用的对象中,一旦我们重新绑定这个对象到`GL_WINDOW_TARGET`位置,这些选项就会重新生效。

|

||||

|

||||

!!! attention

|

||||

|

||||

目前提供的示例代码只是OpenGL如何操作的一个大致描述,通过阅读以后的教程你会遇到很多实际的例子。

|

||||

|

||||

使用对象的一个好处是在程序中,我们不止可以定义一个对象,并设置它们的选项,每个对象都可以是不同的设置。在我们执行一个使用OpenGL状态的操作的时候,只需要绑定含有需要的设置的对象即可。比如说我们有一些作为3D模型数据(一栋房子或一个人物)的容器对象,在我们想绘制其中任何一个模型的时候,只需绑定一个包含对应模型数据的对象就可以了(当然,我们需要先创建并设置对象的选项)。拥有数个这样的对象允许我们指定多个模型,在想画其中任何一个的时候,直接将对应的对象绑定上去,便不需要再重复设置选项了。

|

||||

|

||||

## 让我们开始吧

|

||||

|

||||

你现在已经知道一些OpenGL的相关知识了,OpenGL规范和库,OpenGL幕后大致的运作流程,以及OpenGL使用的一些传统技巧。不要担心你还没有完全消化它们,后面的教程我们会仔细地讲解每一个步骤,你会通过足够的例子来真正掌握OpenGL。如果你已经做好了开始下一步的准备,我们可以在[这里](02 Creating a window.md)开始创建OpenGL上下文以及我们的第一个窗口了。

|

||||

|

||||

## 附加资源

|

||||

|

||||

- [opengl.org](https://www.opengl.org/):OpenGL官方网站。

|

||||

- [OpenGL registry](https://www.opengl.org/registry/):包含OpenGL各版本的规范和扩展。

|

||||

@@ -1,147 +0,0 @@

|

||||

# 创建窗口

|

||||

|

||||

原文 | [Creating a window](http://learnopengl.com/#!Getting-started/Creating-a-window)

|

||||

---|---

|

||||

作者 | JoeyDeVries

|

||||

翻译 | gjy_1992

|

||||

校对 | Geequlim

|

||||

|

||||

在我们画出出色的效果之前,首先要做的就是创建一个OpenGL上下文(Context)和一个用于显示的窗口。然而,这些操作在每个系统上都是不一样的,OpenGL有目的的抽象(Abstract)这些操作。这意味着我们不得不自己处理创建窗口,定义OpenGL上下文以及处理用户输入。

|

||||

|

||||

幸运的是,有一些库已经提供了我们所需的功能,其中一部分是特别针对OpenGL的。这些库节省了我们书写平台相关代码的时间,提供给我们一个窗口和上下文用来渲染。最流行的几个库有GLUT,SDL,SFML和GLFW。在教程里我们将使用**GLFW**。

|

||||

|

||||

## GLFW

|

||||

|

||||

GLFW是一个专门针对OpenGL的C语言库,它提供了一些渲染物件所需的最低限度的接口。它允许用户创建OpenGL上下文,定义窗口参数以及处理用户输入。

|

||||

|

||||

这一节和下一节的内容是建立GLFW环境,并保证它恰当地创建窗口和OpenGL上下文。本教程会一步步从获取,编译,链接GLFW库讲起。我们使用Microsoft Visual Studio 2012 IDE,如果你用的不是它(或者只是Visual Studio的旧版本)请不要担心,大多数IDE上的操作都是类似的。Visual Studio 2012(或其他版本)可以从微软网站上免费下载(选择Express版本或Community版本)。

|

||||

|

||||

## 构建GLFW

|

||||

|

||||

GLFW可以从它们网站的[下载页](http://www.glfw.org/download.html)上获取。GLFW已经有针对Visual Studio 2012/2013的预编译的二进制版本和相应的头文件,但是为了完整性我们将从编译源代码开始,所以需要下载**源代码包**。

|

||||

|

||||

|

||||

!!! Attention

|

||||

|

||||

当你下载二进制版本时,请下载32位的版本而不是64位的除非你清楚你在做什么。大部分读者报告64位版本会出现很多奇怪的问题。

|

||||

|

||||

|

||||

一旦下载完了源码包,解压到某处。我们只关心里面的这些内容:

|

||||

|

||||

- 编译生成的库

|

||||

- **include**文件夹

|

||||

|

||||

从源代码编译库可以保证生成的目标代码是针对你的操作系统和CPU的,而一个预编译的二进制代码并不保证总是适合。提供源代码的一个问题是不是每个人都用相同的IDE来编译,因而提供的工程文件可能和一些人的IDE不兼容。所以人们只能从.cpp和.h文件来自己建立工程,这是一项笨重的工作。因此诞生了一个叫做CMake的工具。

|

||||

|

||||

### CMake

|

||||

|

||||

CMake是一个工程文件生成工具,可以使用预定义好的CMake脚本,根据用户的选择生成不同IDE的工程文件。这允许我们从GLFW源码里创建一个Visual Studio 2012工程文件。首先,我们需要从[这里](http://www.cmake.org/cmake/resources/software.html)下载安装CMake。我们选择Win32安装程序。

|

||||

|

||||

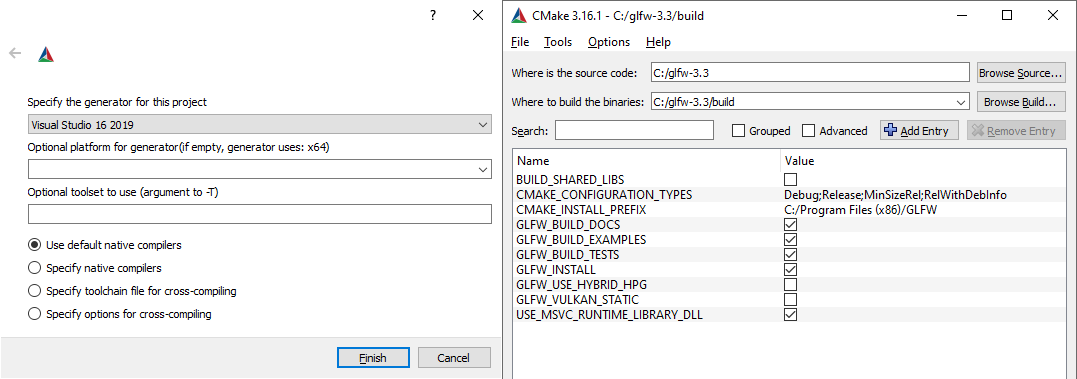

一旦CMake安装成功,你可以选择从命令行或者GUI启动CMake,为了简易我们选择后者。CMake需要一个源代码目录和一个存放编译结果的目标文件目录。源代码目录我们选择GLFW的源代码的根目录,然后我们新建一个_build_文件夹来作为目标目录。

|

||||

|

||||

|

||||

|

||||

之后,点击**Configure(设置)**按钮,我们选择生成的目标平台为**Visual Studio 11**(因为Visual Studio 2012的内部版本号是11.0)。CMake会显示可选的编译选项,这里我们使用默认设置,再次点击**Configure(设置)**按钮,保存这些设置。保存之后,我们可以点击**Generate(生成)**按钮,生成的工程文件就会出现在你的*build*文件夹中。

|

||||

|

||||

### 编译

|

||||

|

||||

在**build**文件夹里可以找到**GLFW.sln**文件,用Visual Studio 2012打开。因为CMake已经配置好了项目所以我们直接点击**Build Solution(构建解决方案)**然后编译的结果**glfw3.lib**就会出现在**src/Debug**文件夹内。(注意我们现在使用的glfw的版本号为3.1)

|

||||

|

||||

生成库之后,我们需要让IDE知道库和头文件的位置。有两种方法:

|

||||

|

||||

1. 找到IDE或者编译器的**/lib**和**/include**文件夹,之后添加GLFW的**include**目录到**/include**里去,相似的将**glfw3.lib**添加到**/lib**里去。这不是推荐的方式,因为很难去追踪library/include文件夹,而且重新安装IDE/Compiler可能会导致这些文件丢失。

|

||||

2. 推荐的方式是建立一个新的目录包含所有的第三方库文件和头文件,并且在你的IDE/Compiler中指定这些文件夹。我个人使用一个单独的文件夹包含**Libs**和**Include**文件夹,在这里存放OpenGL工程用到的所有第三方库和头文件。这样我的所有第三方库都在同一个路径(并且应该在你的多台电脑间共享),然而要求是每次新建一个工程我们都需要告诉IDE/编译器在哪能找到这些文件

|

||||

|

||||

完成上面步骤后,我们就可以使用GLFW创建我们的第一个OpenGL工程了!

|

||||

|

||||

## 我们的第一个工程

|

||||

|

||||

现在,让我们打开Visual Studio,创建一个新的工程。如果提供了多个选项,选择Visual C++,然后选择**空工程(Empty Project)**,别忘了给你的工程起一个合适的名字。现在我们有了一个空的工程去创建我们的OpenGL程序。

|

||||

|

||||

## 链接(Linking)

|

||||

|

||||

为了使我们的程序使用GLFW,我们需要把GLFW库**链接(Link)**进工程。于是我们需要在链接器的设置里写上**glfw3.lib**。但是我们的工程还不知道在哪寻找这个文件,于是我们首先需要将我们放第三方库的目录添加进设置。

|

||||

|

||||

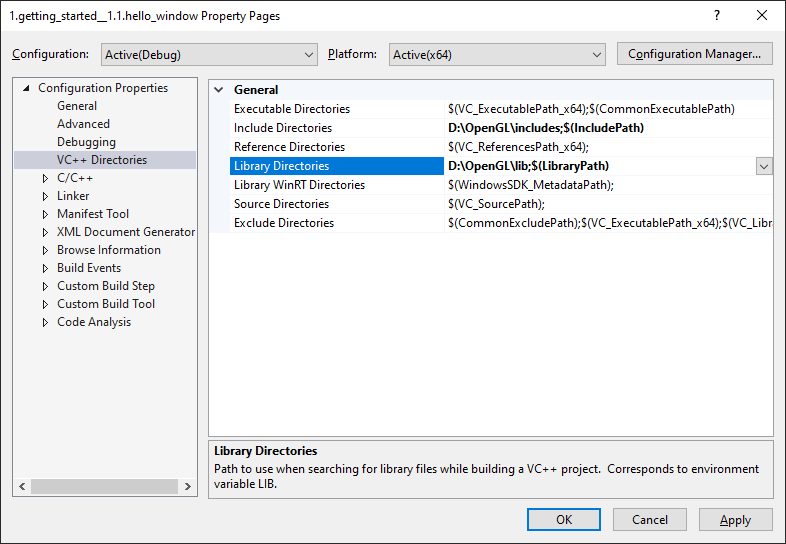

为了添加这些目录,我们首先进入Project Properties(工程属性)(在解决方案窗口里右键项目),然后选择**VC++ Directories**选项卡(如下图)。在下面的两栏添加目录:

|

||||

|

||||

|

||||

|

||||

从这里你可以把自己的目录加进去从而工程知道从哪去寻找库文件和头文件。可以手动把目录加在后面,也可以点**<Edit..>**选项,下面的图是Include Directories的设置:

|

||||

|

||||

|

||||

|

||||

这里可以添加任意多个目录,IDE会从这些目录里寻找头文件。所以只要你将GLFW的**Include**文件夹加进路径中,你就可以使用**<GLFW/..>**来引用头文件。库文件也是一样的。

|

||||

|

||||

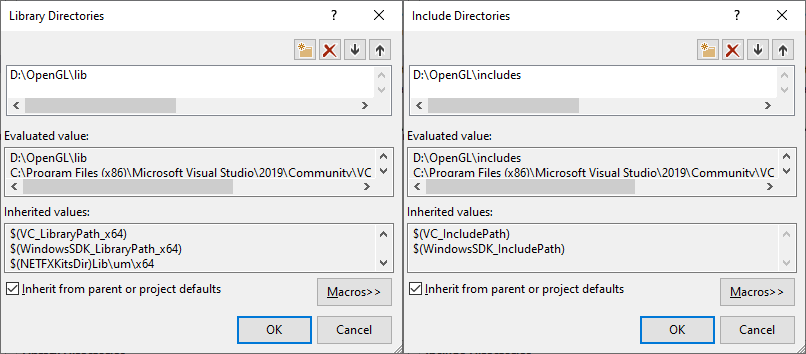

现在VS可以找到我们链接GLFW需要的所有文件了。最后需要在**Linker(链接器)**选项卡里的**Input**选项卡里添加**glfw3.lib**这个文件:

|

||||

|

||||

|

||||

|

||||

要链接一个库我们必须告诉链接器它的文件名。因为我们的库名字是**glfw3.lib**,我们把它加到**Additional Dependencies**域里面(手动或者使用**<Edit..>**选项)。这样GLFW就会被链接进我们的工程。除了GLFW,你也需要链接OpenGL的库,但是这个库可能因为系统的不同而有一些差别。

|

||||

|

||||

### Windows上的OpenGL库

|

||||

|

||||

如果你是Windows平台,**opengl32.lib**已经随着Microsoft SDK装进了Visual Studio的默认目录,所以Windows上我们只需将**opengl32.lib**添加进Additional Dependencies。

|

||||

|

||||

### Linux上的OpenGL库

|

||||

|

||||

在Linux下你需要链接**libGl.so**,所以要添加**-lGL**到你的链接器设置里。如果找不到这个库你可能需要安装Mesa,NVidia或AMD的开发包,这部分因平台而异就不仔细讲解了。

|

||||

|

||||

现在,如果你添加好了GLFW和OpenGL库,你可以用如下方式添加GLFW头文件:

|

||||

|

||||

```c++

|

||||

#include <GLFW\glfw3.h>

|

||||

```

|

||||

|

||||

这个头文件包含了GLFW的设置。

|

||||

|

||||

## GLEW

|

||||

|

||||

到这里,我们仍然有一件事要做。因为OpenGL只是一个规范,具体的实现是由驱动开发商针对特定显卡实现的。由于显卡驱动版本众多,大多数函数都无法在编译时确定下来,需要在运行时获取。开发者需要运行时获取函数地址并保存下来供以后使用。取得地址的方法因平台而异,Windows下看起来类似这样:

|

||||

|

||||

```c++

|

||||

// 定义函数类型

|

||||

typedef void (*GL_GENBUFFERS) (GLsizei, GLuint*);

|

||||

// 找到正确的函数并赋值给函数指针

|

||||

GL_GENBUFFERS glGenBuffers = (GL_GENBUFFERS)wglGetProcAddress("glGenBuffers");

|

||||

// 现在函数可以被正常调用了

|

||||

GLuint buffer;

|

||||

glGenBuffers(1, &buffer);

|

||||

```

|

||||

|

||||

你可以看到代码复杂而笨重,因为我们对于每个函数都必须这样。幸运的是,有一个针对此目的的库,GLEW,是目前最流行的做这件事的方式。

|

||||

|

||||

### 编译和链接GLEW

|

||||

|

||||

GLEW是OpenGL Extension Wrangler Library的缩写,它管理我们上面提到的一系列繁琐的任务。因为GLEW也是一个库,我们同样需要链接进工程。GLEW可以从[这里](http://glew.sourceforge.net/index.html)下载,你可以选择下载二进制版本或者下载源码编译。记住,优先选择32位的二进制版本。

|

||||

|

||||

我们使用GLEW的静态版本glew32s.lib(注意这里的's'),用如上的方式添加其库文件和头文件,最后在链接器的选项里加上glew32s.lib。注意GLFW3也是编译成了一个静态库。

|

||||

|

||||

|

||||

!!! Important

|

||||

|

||||

**静态(Static)**链接是指编译时就将库代码里的内容合并进二进制文件。优点就是你不需要再放额外的文件,只需要发布你最终的二进制代码文件。缺点就是你的程序会变得更大,另外当库有升级版本时,你必须重新进行编译。

|

||||

**动态(Dynamic)**链接是指一个库通过.dll或.so的方式存在,它的代码与你的二进制文件的代码是分离的。优点是使你的程序大小变小并且更容易升级,缺点是你发布时必须带上这些dll。

|

||||

|

||||

|

||||

如果你希望静态链接GLEW,必须在包含GLEW头文件之前定义预编译宏`GLEW_STATIC`:

|

||||

|

||||

```c++

|

||||

#define GLEW_STATIC

|

||||

#include <GL/glew.h>

|

||||

```

|

||||

|

||||

如果你希望动态链接,那么就不要定义这个宏。但是使用动态链接的话你需要拷贝一份dll文件到你的应用程序目录。

|

||||

|

||||

!!! Important

|

||||

|

||||

对于Linux用户建议使用这个命令行`-lGLEW -lglfw3 -lGL -lX11 -lpthread -lXrandr -lXi`。没有正确链接相应的库会产生*undefined reference*(未定义的引用)这个错误。

|

||||

|

||||

我们现在成功编译了GLFW和GLEW库,我们将进入[下一节](http://learnopengl-cn.readthedocs.org/zh/latest/01%20Getting%20started/03%20Hello%20Window/)去使用GLFW和GLEW来设置OpenGL上下文并创建窗口。记住确保你的头文件和库文件的目录设置正确,以及链接器里引用的库文件名正确。如果仍然遇到错误,请参考额外资源中的例子。

|

||||

|

||||

##额外的资源

|

||||

|

||||

- [Building applications](http://www.opengl-tutorial.org/miscellaneous/building-your-own-c-application/): 提供了很多编译链接相关的信息以及一大批错误的解决方法。

|

||||

- [GLFW with Code::Blocks](http://wiki.codeblocks.org/index.php?title=Using_GLFW_with_Code::Blocks):使用Code::Blocks IDE编译GLFW。

|

||||

- [Running CMake](http://www.cmake.org/runningcmake/): 简要的介绍如何在Windows和Linux上使用CMake。

|

||||

- [Writing a build system under Linux](http://learnopengl.com/demo/autotools_tutorial.txt): Wouter Verholst写的一个自动工具的教程,关于如何在Linux上建立编译环境,尤其是针对这些教程。

|

||||

- [Polytonic/Glitter](https://github.com/Polytonic/Glitter): 一个简单的样板项目,它已经提前配置了所有相关的库;如果你想要很方便地搞到一个LearnOpenGL教程的范例工程,这是一个很好的东西。

|

||||

@@ -1,201 +0,0 @@

|

||||

# 你好,窗口

|

||||

|

||||

原文 | [Hello Window](http://learnopengl.com/#!Getting-started/Hello-Window)

|

||||

---|---

|

||||

作者 | JoeyDeVries

|

||||

翻译 | Geequlim

|

||||

校对 | Geequlim

|

||||

|

||||

|

||||

上一节中我们获取并编译了GLFW和GLEW这两个开源库,现在我们就可以使用它们来创建一个OpenGL绘图窗口了。首先,新建一个`.cpp`文件,然后把下面的代码粘贴到该文件的最前面。注意,之所以定义`GLEW_STATIC`宏,是因为我们使用GLEW的静态链接库。

|

||||

|

||||

```c++

|

||||

// GLEW

|

||||

#define GLEW_STATIC

|

||||

#include <GL/glew.h>

|

||||

// GLFW

|

||||

#include <GLFW/glfw3.h>

|

||||

```

|

||||

|

||||

!!! Attention

|

||||

|

||||

请确认在包含GLFW的头文件之前包含了GLEW的头文件。在包含glew.h头文件时会引入许多OpenGL必要的头文件(例如GL/gl.h),所以#include <GL/glew.h>应放在引入其他头文件的代码之前。

|

||||

|

||||

接下来我们创建`main`函数,并做一些初始化GLFW的操作:

|

||||

|

||||

```c++

|

||||

int main()

|

||||

{

|

||||

glfwInit();

|

||||

glfwWindowHint(GLFW_CONTEXT_VERSION_MAJOR, 3);

|

||||

glfwWindowHint(GLFW_CONTEXT_VERSION_MINOR, 3);

|

||||

glfwWindowHint(GLFW_OPENGL_PROFILE, GLFW_OPENGL_CORE_PROFILE);

|

||||

glfwWindowHint(GLFW_RESIZABLE, GL_FALSE);

|

||||

|

||||

return 0;

|

||||

}

|

||||

```

|

||||

|

||||

首先我们在`main`函数中调用`glfwInit`函数来初始化GLFW,然后我们可以使用`glfwWindowHint`函数来配置GLFW。`glfwWindowHint`函数的第一个参数表示我们要进行什么样的配置,我们可以选择大量以`GLFW_`开头的枚举值;第二个参数接受一个整形,用来设置这个配置的值。该函数的所有的选项以及对应的值都可以在 [GLFW's window handling](http://www.glfw.org/docs/latest/window.html#window_hints) 这篇文档中找到。如果你现在编译你的cpp文件会得到大量的连接错误,这是因为你还需要进一步设置GLFW。

|

||||

|

||||

由于本站的教程都是基于OpenGL3.3以后的版本展开讨论的,所以我们需要告诉GLFW我们要使用的OpenGL版本是3.3,这样GLFW会在创建OpenGL上下文时做出适当的调整。这也可以确保用户在没有适当的OpenGL版本支持的情况下无法运行。在这里我们告诉GLFW想要的OpenGL版本号是3.3,并且不允许用户调整窗口的大小。我们明确地告诉GLFW我们想要使用核心模式(Core-profile),这将导致我们无法使用那些已经废弃的API,而这不正是一个很好的提醒吗?当我们不小心用了旧功能时报错,就能避免使用一些被废弃的用法了。如果你使用的是Mac OSX系统你还需要加下面这行代码这些配置才能起作用:

|

||||

|

||||

```c++

|

||||

glfwWindowHint(GLFW_OPENGL_FORWARD_COMPAT, GL_TRUE);

|

||||

```

|

||||

|

||||

!!! Important

|

||||

|

||||

请确认您的系统支持OpenGL3.3或更高版本,否则此应用有可能会崩溃或者出现不可预知的错误。可以通过运行glew附带的glxinfo程序或者其他的工具(例如[OpenGL Extension Viewer](http://download.cnet.com/OpenGL-Extensions-Viewer/3000-18487_4-34442.html)来查看你的OpenGL版本。如果你的OpenGL版本低于3.3请更新你的驱动程序或者有必要的话更新设备。

|

||||

|

||||

接下来我们创建一个窗口对象,这个窗口对象中具有和窗口相关的许多数据,而且会被GLFW的其他函数频繁地用到。

|

||||

|

||||

```c++

|

||||

GLFWwindow* window = glfwCreateWindow(800, 600, "LearnOpenGL", nullptr, nullptr);

|

||||

if (window == nullptr)

|

||||

{

|

||||

std::cout << "Failed to create GLFW window" << std::endl;

|

||||

glfwTerminate();

|

||||

return -1;

|

||||

}

|

||||

glfwMakeContextCurrent(window);

|

||||

```

|

||||

|

||||

`glfwCreateWindow`函数需要窗口的宽和高作为它的前两个参数;第三个参数表示只这个窗口的名称(标题),这里我们使用**"LearnOpenGL"**,当然你也可以使用你喜欢的名称;最后两个参数我们暂时忽略,先置为空指针就行。它的返回值`GLFWwindow`对象的指针会在其他的GLFW操作中使用到。创建完窗口我们就可以通知GLFW给我们的窗口在当前的线程中创建我们等待已久的OpenGL上下文了。

|

||||

|

||||

### GLEW

|

||||

|

||||

在之前的教程中已经提到过,GLEW是用来管理OpenGL的函数指针的,所以在调用任何OpenGL的函数之前我们需要初始化GLEW。

|

||||

|

||||

```c++

|

||||

glewExperimental = GL_TRUE;

|

||||

if (glewInit() != GLEW_OK)

|

||||

{

|

||||

std::cout << "Failed to initialize GLEW" << std::endl;

|

||||

return -1;

|

||||

}

|

||||

```

|

||||

|

||||

请注意,我们在初始化GLEW之前设置`glewExperimental`变量的值为`GL_TRUE`,这样做能让GLEW在管理OpenGL的函数指针时更多地使用现代化的技术,如果把它设置为`GL_FALSE`的话可能会在使用OpenGL的核心模式(Core-profile)时出现一些问题。

|

||||

|

||||

### 视口(Viewport)

|

||||

|

||||

在我们绘制之前还有一件重要的事情要做,我们必须告诉OpenGL渲染窗口的尺寸大小,这样OpenGL才只能知道要显示数据的窗口坐标。我们可以通过调用`glViewport`函数来设置这些维度:

|

||||

|

||||

```c++

|

||||

glViewport(0, 0, 800, 600);

|

||||

```

|

||||

|

||||

前两个参数设置窗口左下角的位置。第三个和第四个参数设置渲染窗口的宽度和高度,我们设置成与GLFW的窗口的宽高大小,我们也可以将这个值设置成比窗口小的数值,然后所有的OpenGL渲染将会显示在一个较小的区域。

|

||||

|

||||

!!!Important

|

||||

|

||||

OpenGL使用`glViewport`定义的位置和宽高进行位置坐标的转换,将OpenGL中的位置坐标转换为你的屏幕坐标。例如,OpenGL中的坐标(0.5,0.5)有可能被转换为屏幕中的坐标(200,450)。注意,OpenGL只会把-1到1之间的坐标转换为屏幕坐标,因此在此例中(-1,1)转换为屏幕坐标是(0,600)。

|

||||

|

||||

## 准备好你的引擎

|

||||

|

||||

我们可不希望只绘制一个图像之后我们的应用程序就关闭窗口并立即退出。我们希望程序在我们明确地关闭它之前一直保持运行状态并能够接受用户输入。因此,我们需要在程序中添加一个while循环,我们可以把它称之为游戏循环(Game Loop),这样我们的程序就能在我们让GLFW退出前保持运行了。下面几行的代码就实现了一个简单的游戏循环:

|

||||

|

||||

```c++

|

||||

while(!glfwWindowShouldClose(window))

|

||||

{

|

||||

glfwPollEvents();

|

||||

glfwSwapBuffers(window);

|

||||

}

|

||||

```

|

||||

|

||||

- `glfwWindowShouldClose`函数在我们每次循环的开始前检查一次GLFW是否准备好要退出,如果是这样的话该函数返回true然后游戏循环便结束了,之后为我们就可以关闭应用程序了。

|

||||

- `glfwPollEvents`函数检查有没有触发什么事件(比如键盘有按钮按下、鼠标移动等)然后调用对应的回调函数(我们可以手动设置这些回调函数)。我们一般在游戏循环的一开始就检查事件。

|

||||

- 调用`glfwSwapBuffers`会交换缓冲区(储存着GLFW窗口每一个像素颜色的缓冲区)

|

||||

|

||||

|

||||

!!! Important

|

||||

|

||||

**双缓冲区(Double buffer)**

|

||||

|

||||

应用程序使用单缓冲区绘图可能会存在图像闪烁的问题。 这是因为生成的图像不是一下子被绘制出来的,而是按照从左到右,由上而下逐像素地绘制而成的。最终图像不是在瞬间显示给用户,而是通过一步一步地计算结果绘制的,这可能会花费一些时间。为了规避这些问题,我们应用双缓冲区渲染窗口应用程序。前面的缓冲区保存着计算后可显示给用户的图像,被显示到屏幕上;所有的的渲染命令被传递到后台的缓冲区进行计算。当所有的渲染命令执行结束后,我们交换前台缓冲和后台缓冲,这样图像就立即呈显出来,之后清空缓冲区。

|

||||

|

||||

### 最后一件事

|

||||

|

||||

当游戏循环结束后我们需要释放之前的操作分配的资源,我们可以在main函数的最后调用`glfwTerminate`函数来释放GLFW分配的内存。

|

||||

|

||||

```c++

|

||||

glfwTerminate();

|

||||

return 0;

|

||||

```

|

||||

|

||||

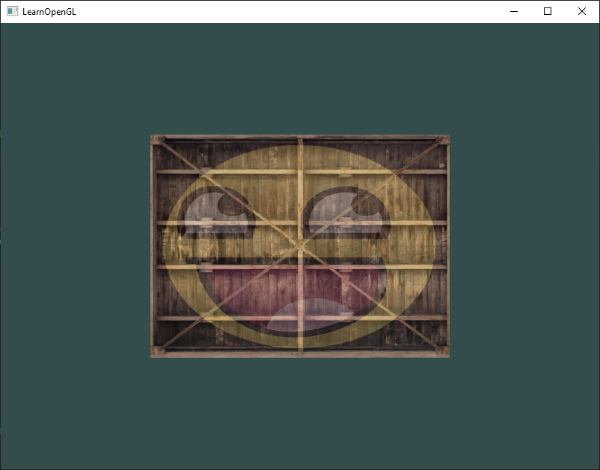

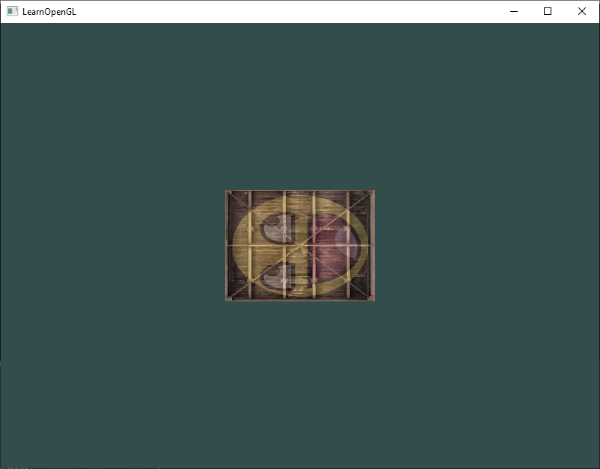

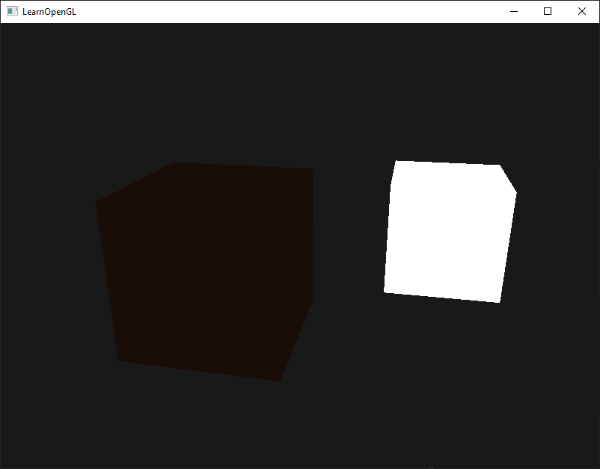

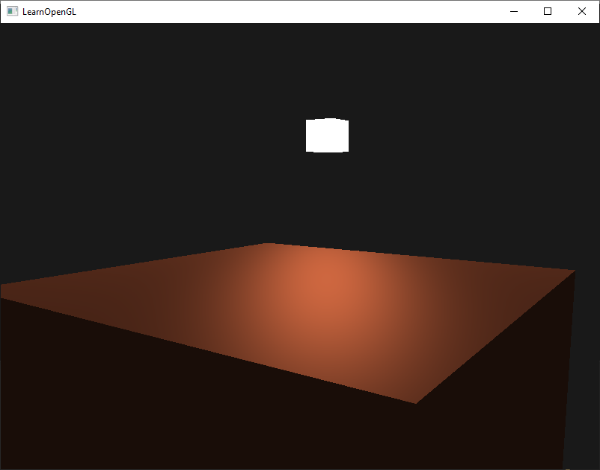

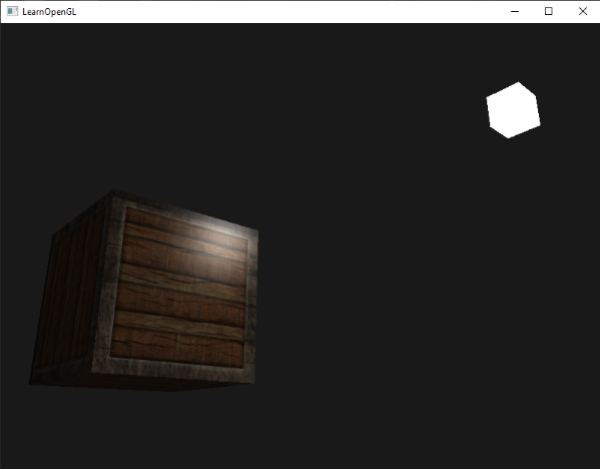

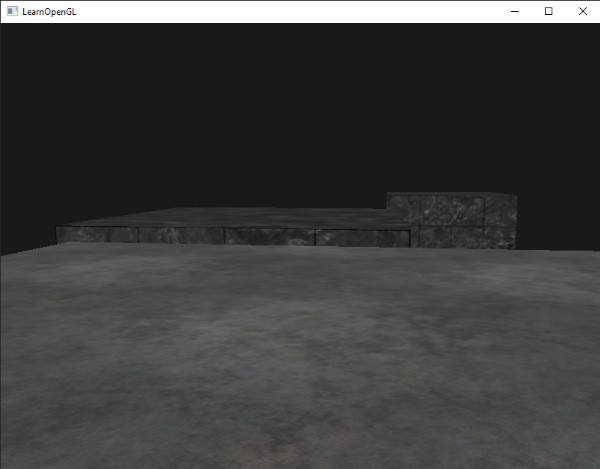

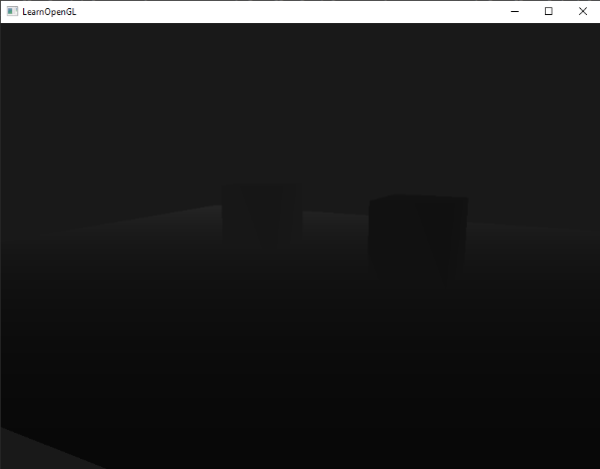

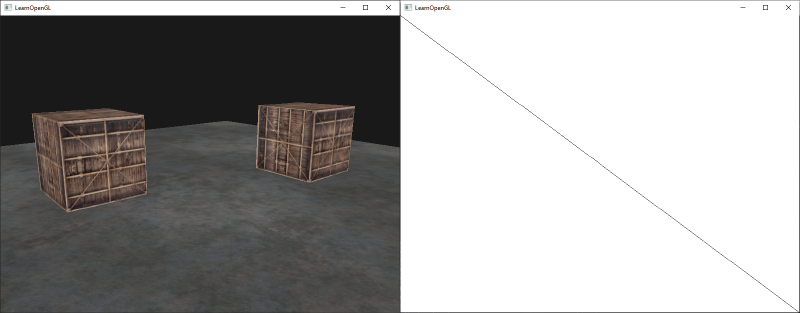

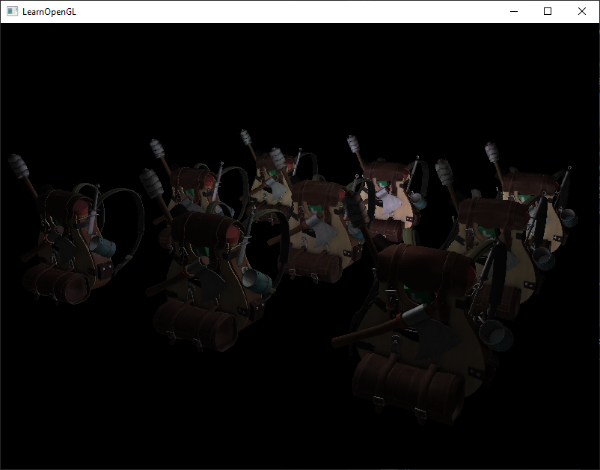

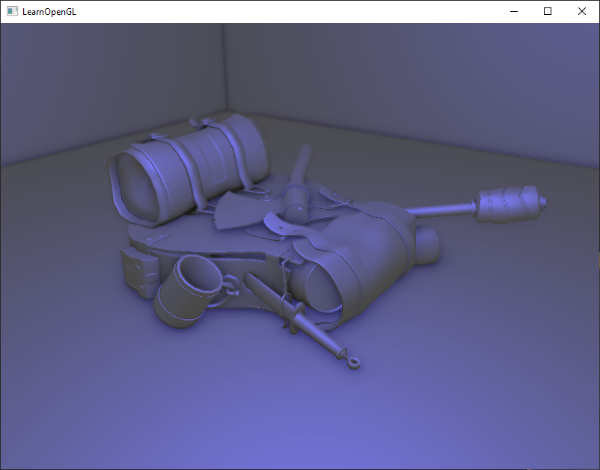

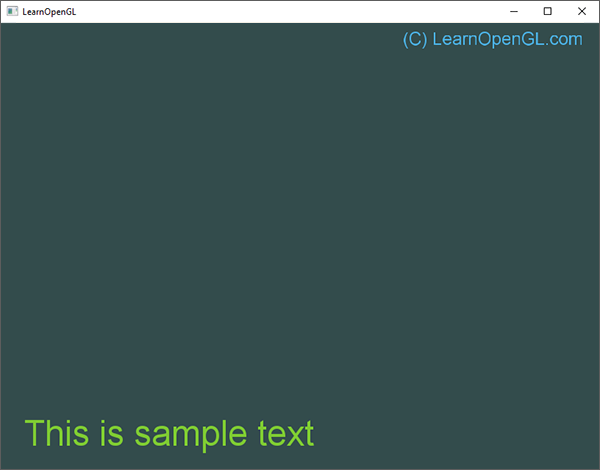

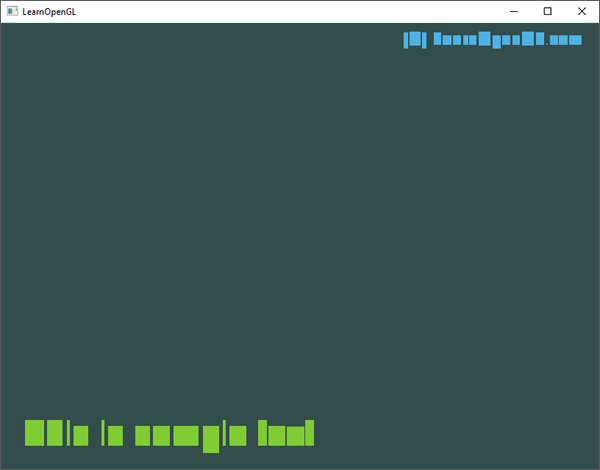

这样便能清空GLFW分配的内存然后正确地退出应用程序。现在你可以尝试编译并运行你的应用程序了,你将会看到如下的一个黑色窗口:

|

||||

|

||||

|

||||

|

||||

如果你没有编译通过或者有什么问题的话,首先请检查你程序的的链接选项是否正确

|

||||

。然后对比本教程的代码,检查你的代码是不是哪里写错了,你也可以[点击这里](http://learnopengl.com/code_viewer.php?code=getting-started/hellowindow)获取我的完整代码。

|

||||

|

||||

### 输入

|

||||

|

||||

我们同样也希望能够在GLFW中实现一些键盘控制,这是通过设置GLFW的**回调函数(Callback Function)**来实现的。回调函数事实上是一个函数指针,当我们为GLFW设置回调函数后,GLWF会在恰当的时候调用它。**按键回调(KeyCallback)**是众多回调函数中的一种,当我们为GLFW设置按键回调之后,GLFW会在用户有键盘交互时调用它。该回调函数的原型如下所示:

|

||||

|

||||

```c++

|

||||

void key_callback(GLFWwindow* window, int key, int scancode, int action, int mode);

|

||||

```

|

||||

|

||||

按键回调函数接受一个`GLFWwindow`指针作为它的第一个参数;第二个整形参数用来表示事件的按键;第三个整形参数描述用户是否有第二个键按下或释放;第四个整形参数表示事件类型,如按下或释放;最后一个参数是表示是否有Ctrl、Shift、Alt、Super等按钮的操作。GLFW会在恰当的时候调用它,并为各个参数传入适当的值。

|

||||

|

||||

|

||||

```c++

|

||||

void key_callback(GLFWwindow* window, int key, int scancode, int action, int mode)

|

||||

{

|

||||

// 当用户按下ESC键,我们设置window窗口的WindowShouldClose属性为true

|

||||

// 关闭应用程序

|

||||

if(key == GLFW_KEY_ESCAPE && action == GLFW_PRESS)

|

||||

glfwSetWindowShouldClose(window, GL_TRUE);

|

||||

}

|

||||

```

|

||||

|

||||

在这个`key_callback`函数中,它检测键盘是否按下了Escape键。如果键的确按下了(不释放),我们使用`glfwSetwindowShouldClose`函数设定`WindowShouldClose`属性为true从而关闭GLFW。main函数的while循环下一次的检测将失败并且程序关闭。

|

||||

|

||||

最后一件事就是通过GLFW使用适合的回调来注册我们的函数,代码是这样的:

|

||||

|

||||

```c++

|

||||

glfwSetKeyCallback(window, key_callback);

|

||||

```

|

||||

|

||||

除了按键回调函数之外,我们还能为GLFW注册其他的回调函数。例如,我们可以注册一个函数来处理窗口尺寸变化、处理一些错误信息等。我们可以在创建窗口之后到开始游戏循环之前注册各种回调函数。

|

||||

|

||||

|

||||

### 渲染(Rendering)

|

||||

|

||||

我们要把所有的渲染操作放到游戏循环中,因为我们想让这些渲染操作在每次游戏循环迭代的时候都能被执行。我们将做如下的操作:

|

||||

|

||||

```c++

|

||||

// 程序循环

|

||||

while(!glfwWindowShouldClose(window))

|

||||

{

|

||||

// 检查事件

|

||||

glfwPollEvents();

|

||||

|

||||

// 在这里执行各种渲染操作

|

||||

...

|

||||

|

||||

//交换缓冲区

|

||||

glfwSwapBuffers(window);

|

||||

}

|

||||

```

|

||||

|

||||

为了测试一切都正常,我们想让屏幕清空为一种我们选择的颜色。在每次执行新的渲染之前我们都希望清除上一次循环的渲染结果,除非我们想要看到上一次的结果。我们可以通过调用`glClear`函数来清空屏幕缓冲区的颜色,他接受一个整形常量参数来指定要清空的缓冲区,这个常量可以是`GL_COLOR_BUFFER_BIT`,`GL_DEPTH_BUFFER_BIT`和`GL_STENCIL_BUFFER_BIT`。由于现在我们只关心颜色值,所以我们只清空颜色缓冲区。

|

||||

|

||||

```c++

|

||||

glClearColor(0.2f, 0.3f, 0.3f, 1.0f);

|

||||

glClear(GL_COLOR_BUFFER_BIT);

|

||||

```

|

||||

注意,除了`glClear`之外,我们还要调用`glClearColor`来设置要清空缓冲的颜色。当调用`glClear`函数之后,整个指定清空的缓冲区都被填充为`glClearColor`所设置的颜色。在这里,我们将屏幕设置为了类似黑板的深蓝绿色。

|

||||

|

||||

!!! Important

|

||||

|

||||

你应该能够想起来我们在[OpenGL](http://learnopengl-cn.readthedocs.org/zh/latest/01%20Getting%20started/01%20OpenGL/)教程的内容,`glClearColor`函数是一个状态设置函数,而`glClear`函数则是一个状态应用的函数。

|

||||

|

||||

|

||||

|

||||

此程序的完整源代码可以在[这里](http://learnopengl.com/code_viewer.php?code=getting-started/hellowindow2)找到。

|

||||

|

||||

好了,到目前为止我们已经做好开始在游戏循环中添加许多渲染操作的准备了,我认为我们的闲扯已经够多了,从下一篇教程开始我们将真正的征程。

|

||||

@@ -1,538 +0,0 @@

|

||||

# 你好,三角形

|

||||

|

||||

原文 | [Creating a window](http://www.learnopengl.com/#!Getting-started/Hello-Triangle)

|

||||

---|---

|

||||

作者 | JoeyDeVries

|

||||

翻译 | [Django](http://bullteacher.com/)

|

||||

校对 | Geequlim

|

||||

|

||||

## 图形渲染管线(Pipeline)

|

||||

|

||||

在OpenGL中任何事物都在3D空间中,但是屏幕和窗口是一个2D像素阵列,所以OpenGL的大部分工作都是关于如何把3D坐标转变为适应你屏幕的2D像素。3D坐标转为2D坐标的处理过程是由OpenGL的**图形渲染管线**(Pipeline,大多译为管线,实际上指的是一堆原始图形数据途经一个输送管道,期间经过各种变化处理最终出现在屏幕的过程)管理的。图形渲染管线可以被划分为两个主要部分:第一个部分把你的3D坐标转换为2D坐标,第二部分是把2D坐标转变为实际的有颜色的像素。这个教程里,我们会简单地讨论一下图形渲染管线,以及如何使用它创建一些像素,这对我们来说是有好处的。

|

||||

|

||||

!!! Important

|

||||

|

||||

2D坐标和像素也是不同的,2D坐标是在2D空间中的一个点的非常精确的表达,2D像素是这个点的近似值,它受到你的屏幕/窗口解析度的限制。

|

||||

|

||||

图形渲染管线接收一组3D坐标,然后把它们转变为你屏幕上的有色2D像素。图形渲染管线可以被划分为几个阶段,每个阶段需要把前一个阶段的输出作为输入。所有这些阶段都是高度专门化的(它们有一个特定的函数),它们能简单地并行执行。由于它们的并行执行特性,当今大多数显卡都有成千上万的小处理核心,在GPU上为每一个(渲染管线)阶段运行各自的小程序,从而在图形渲染管线中快速处理你的数据。这些小程序叫做 **着色器**(Shader)。

|

||||

|

||||

有些着色器允许开发者自己配置,我们可以用自己写的着色器替换默认的。这样我们就可以更细致地控制图形渲染管线中的特定部分了,因为它们运行在GPU上,所以它们会节约宝贵的CPU时间。OpenGL着色器是用**OpenGL着色器语言**(OpenGL Shading Language, GLSL)写成的,我们在下一节会花更多时间研究它。

|

||||

|

||||

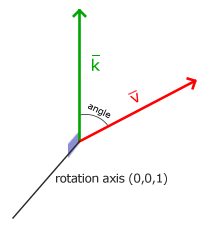

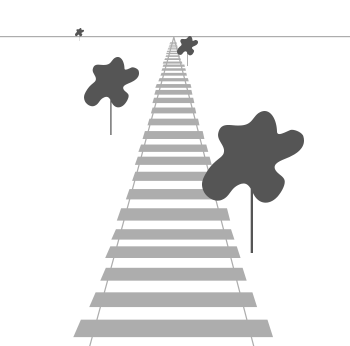

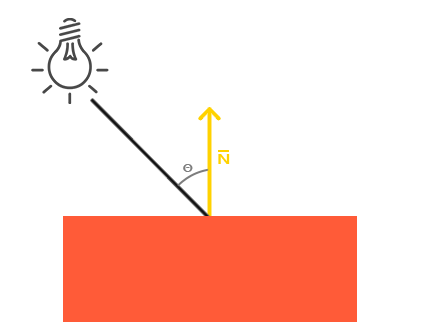

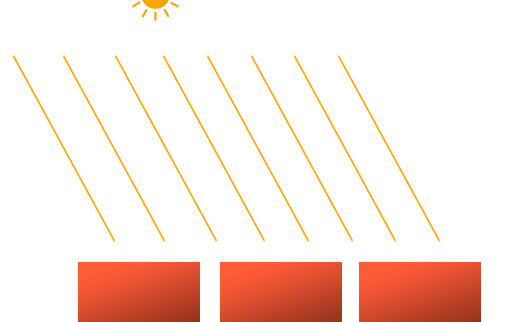

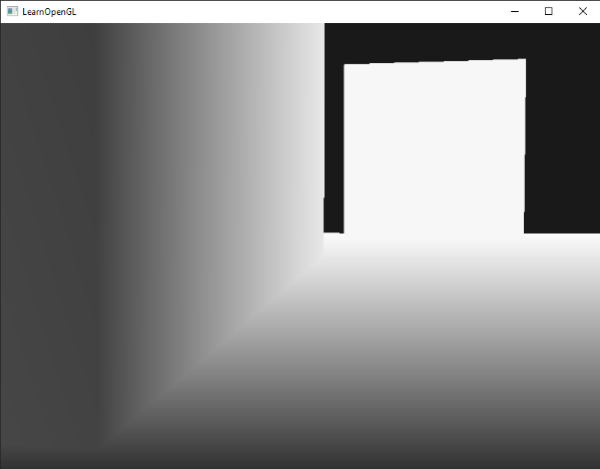

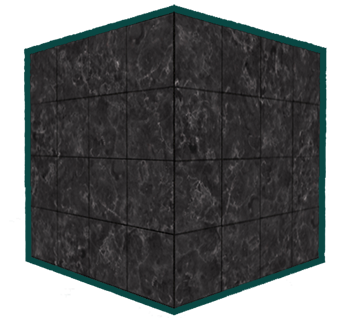

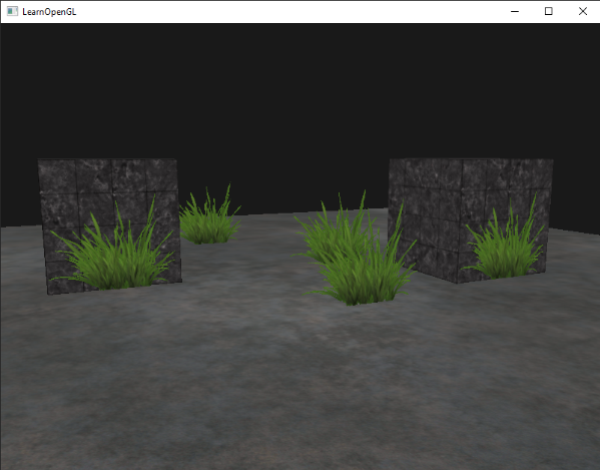

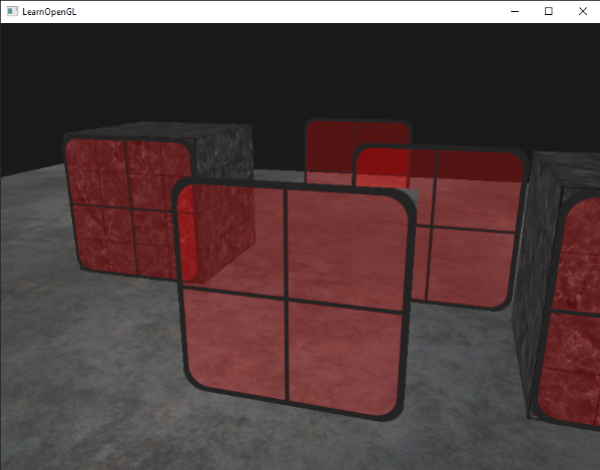

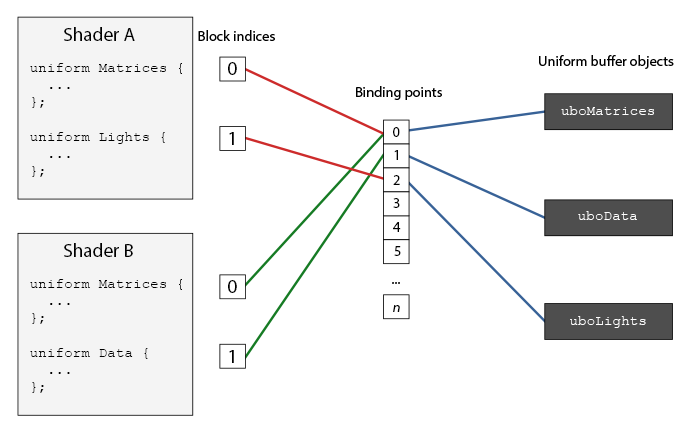

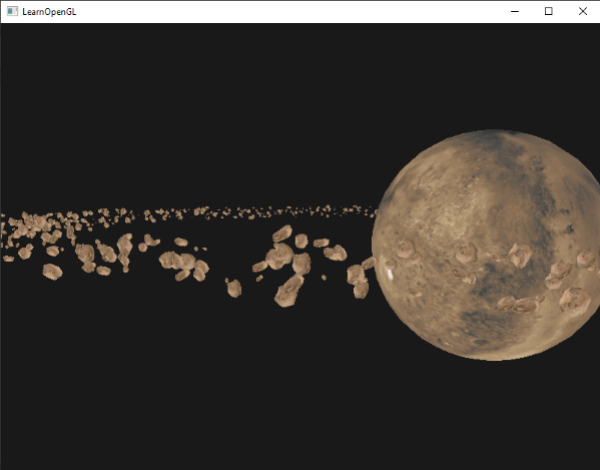

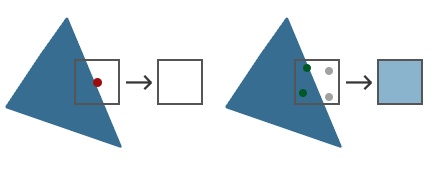

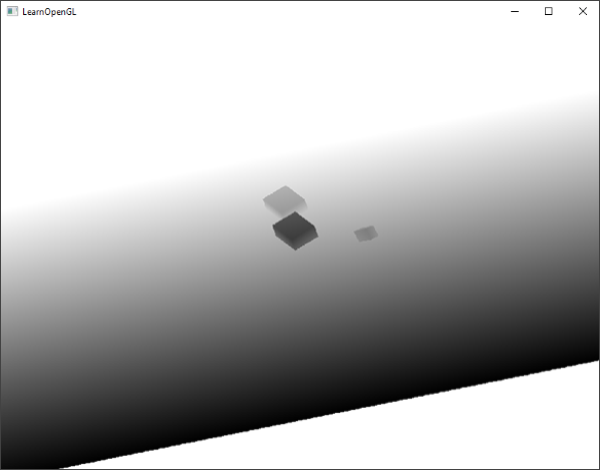

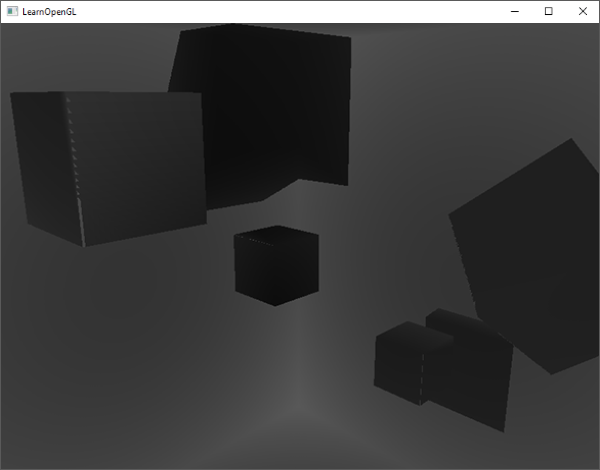

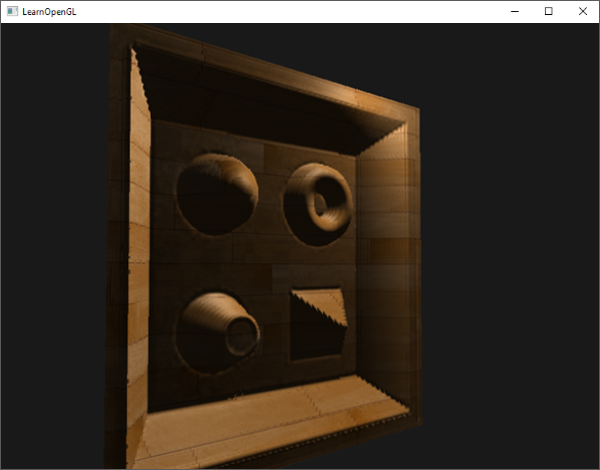

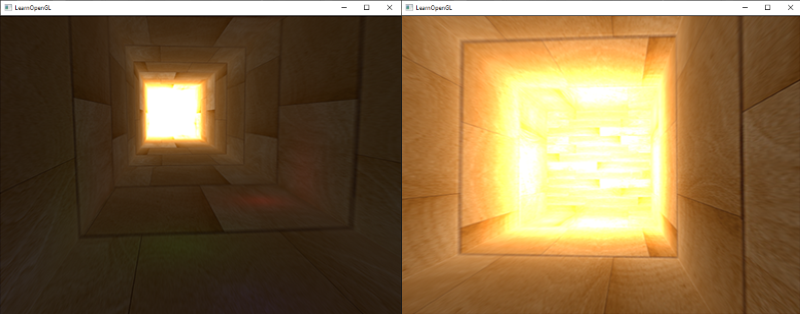

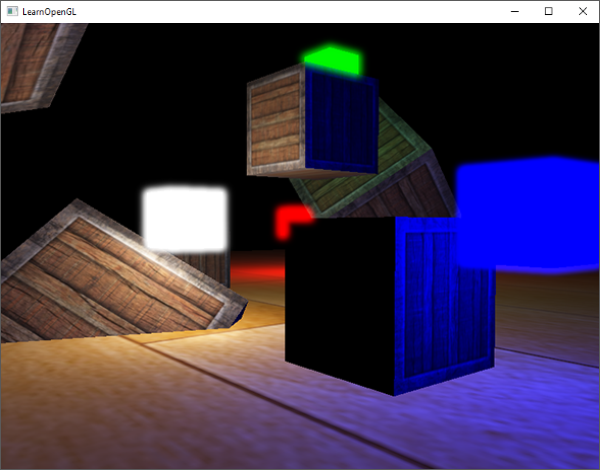

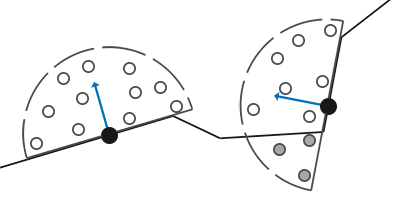

在下面,你会看到一个图形渲染管线的每个阶段的抽象表达。要注意蓝色部分代表的是我们可以自定义的着色器。

|

||||

|

||||

|

||||

|

||||

如你所见,图形渲染管线包含很多部分,每个都是将你的顶点数据转变为最后渲染出来的像素这个大过程中的一个特定阶段。我们会概括性地解释渲染管线的每个部分,从而使你对图形渲染管线的工作方式有个大概了解。

|

||||

|

||||

我们以数组的形式传递3个3D坐标作为图形渲染管线的输入,它用来表示一个三角形,这个数组叫做顶点数据(Vertex Data);这里顶点数据是一些顶点的集合。一个**顶点**是一个3D坐标的集合(也就是x、y、z数据)。而顶点数据是用**顶点属性**(Vertex Attributes)表示的,它可以包含任何我们希望用的数据,但是简单起见,我们还是假定每个顶点只由一个3D位置(译注1)和几个颜色值组成的吧。

|

||||

|

||||

!!! note "译注1"

|

||||

|

||||

当我们谈论一个“位置”的时候,它代表在一个“空间”中所处地点的这个特殊属性;同时“空间”代表着任何一种坐标系,比如x、y、z三维坐标系,x、y二维坐标系,或者一条直线上的x和y的线性关系,只不过二维坐标系是一个扁扁的平面空间,而一条直线是一个很瘦的长长的空间。

|

||||

|

||||

!!! Important

|

||||

|

||||

为了让OpenGL知道我们的坐标和颜色值构成的到底是什么,OpenGL需要你去提示你希望这些数据所表示的是什么类型。我们是希望把这些数据渲染成一系列的点?一系列的三角形?还是仅仅是一个长长的线?做出的这些提示叫做**基本图形**(Primitives),任何一个绘制命令的调用都必须把基本图形类型传递给OpenGL。这是其中的几个:**GL_POINTS**、**GL_TRIANGLES**、**GL_LINE_STRIP**。

|

||||

|

||||

图形渲染管线的第一个部分是**顶点着色器**(Vertex Shader),它把一个单独的顶点作为输入。顶点着色器主要的目的是把3D坐标转为另一种3D坐标(后面会解释),同时顶点着色器允许我们对顶点属性进行一些基本处理。

|

||||

|

||||

**基本图形装配**(Primitive Assembly)阶段把顶点着色器的表示为基本图形的所有顶点作为输入(如果选择的是`GL_POINTS`,那么就是一个单独顶点),把所有点组装为特定的基本图形的形状;本节例子是一个三角形。

|

||||

|

||||

基本图形装配阶段的输出会传递给**几何着色器**(Geometry Shader)。几何着色器把基本图形形式的一系列顶点的集合作为输入,它可以通过产生新顶点构造出新的(或是其他的)基本图形来生成其他形状。例子中,它生成了另一个三角形。

|

||||

|

||||

**细分着色器**(Tessellation Shaders)拥有把给定基本图形**细分**为更多小基本图形的能力。这样我们就能在物体更接近玩家的时候通过创建更多的三角形的方式创建出更加平滑的视觉效果。

|

||||

|

||||

细分着色器的输出会进入**光栅化**(Rasterization也译为像素化)阶段,这里它会把基本图形映射为屏幕上相应的像素,生成供片段着色器(Fragment Shader)使用的片段(Fragment)。在片段着色器运行之前,会执行**裁切**(Clipping)。裁切会丢弃超出你的视图以外的那些像素,来提升执行效率。

|

||||

|

||||

|

||||

!!! Important

|

||||

|

||||

OpenGL中的一个fragment是OpenGL渲染一个独立像素所需的所有数据。

|

||||

|

||||

**片段着色器**的主要目的是计算一个像素的最终颜色,这也是OpenGL高级效果产生的地方。通常,片段着色器包含用来计算像素最终颜色的3D场景的一些数据(比如光照、阴影、光的颜色等等)。

|

||||

|

||||

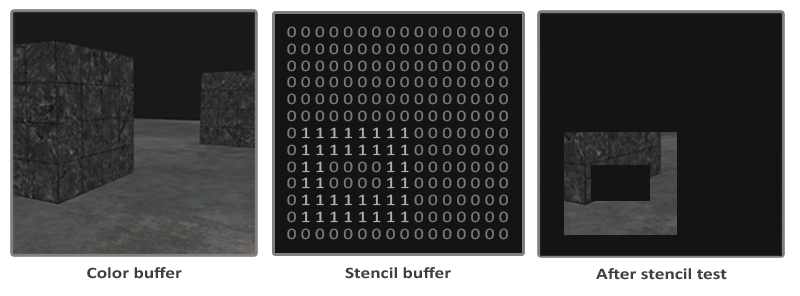

在所有相应颜色值确定以后,最终它会传到另一个阶段,我们叫做**alpha测试**和**混合**(Blending)阶段。这个阶段检测像素的相应的深度(和Stencil)值(后面会讲),使用这些,来检查这个像素是否在另一个物体的前面或后面,如此做到相应取舍。这个阶段也会检查**alpha值**(alpha值是一个物体的透明度值)和物体之间的**混合**(Blend)。所以,即使在片段着色器中计算出来了一个像素所输出的颜色,最后的像素颜色在渲染多个三角形的时候也可能完全不同。

|

||||

|

||||

正如你所见的那样,图形渲染管线非常复杂,它包含很多要配置的部分。然而,对于大多数场合,我们必须做的只是顶点和片段着色器。几何着色器和细分着色器是可选的,通常使用默认的着色器就行了。

|

||||

|

||||

在现代OpenGL中,我们**必须**定义至少一个顶点着色器和一个片段着色器(因为GPU中没有默认的顶点/片段着色器)。出于这个原因,开始学习现代OpenGL的时候非常困难,因为在你能够渲染自己的第一个三角形之前需要一大堆知识。本节结束就是你可以最终渲染出你的三角形的时候,你也会了解到很多图形编程知识。

|

||||

|

||||

## 顶点输入(Vertex Input)

|

||||

|

||||

开始绘制一些东西之前,我们必须给OpenGL输入一些顶点数据。OpenGL是一个3D图形库,所以我们在OpenGL中指定的所有坐标都是在3D坐标里(x、y和z)。OpenGL不是简单的把你所有的3D坐标变换为你屏幕上的2D像素;OpenGL只是在当它们的3个轴(x、y和z)在特定的-1.0到1.0的范围内时才处理3D坐标。所有在这个范围内的坐标叫做**标准化设备坐标**(Normalized Device Coordinates,NDC)会最终显示在你的屏幕上(所有出了这个范围的都不会显示)。

|

||||

|

||||

由于我们希望渲染一个三角形,我们指定所有的这三个顶点都有一个3D位置。我们把它们以`GLfloat`数组的方式定义为标准化设备坐标(也就是在OpenGL的可见区域)中。

|

||||

|

||||

```c++

|

||||

GLfloat vertices[] = {

|

||||

-0.5f, -0.5f, 0.0f,

|

||||

0.5f, -0.5f, 0.0f,

|

||||

0.0f, 0.5f, 0.0f

|

||||

};

|

||||

```

|

||||

|

||||

由于OpenGL是在3D空间中工作的,我们渲染一个2D三角形,它的每个顶点都要有同一个z坐标0.0。在这样的方式中,三角形的每一处的深度(Depth, 译注2)都一样,从而使它看上去就像2D的。

|

||||

|

||||

!!! note "译注2"

|

||||

|

||||

通常深度可以理解为z坐标,它代表一个像素在空间中和你的距离,如果离你远就可能被别的像素遮挡,你就看不到它了,它会被丢弃,以节省资源。

|

||||

|

||||

!!! Important

|

||||

|

||||

**标准化设备坐标(Normalized Device Coordinates, NDC)**

|

||||

|

||||

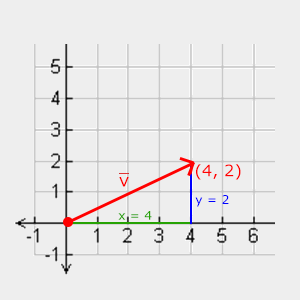

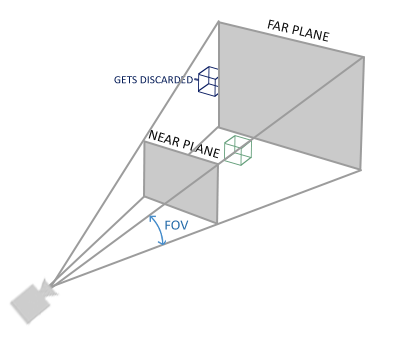

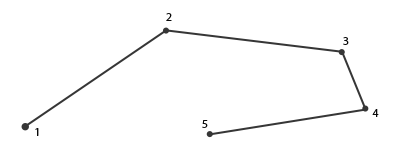

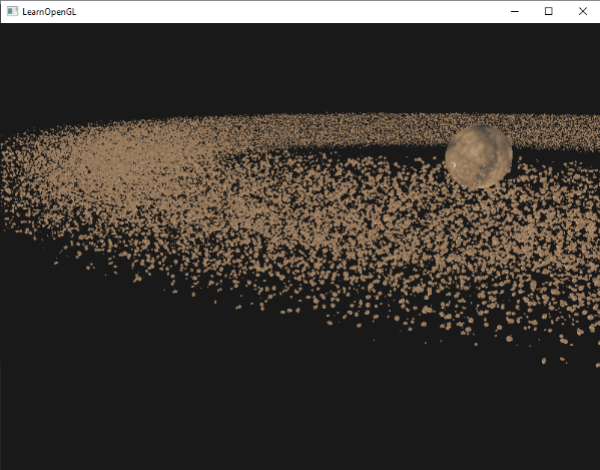

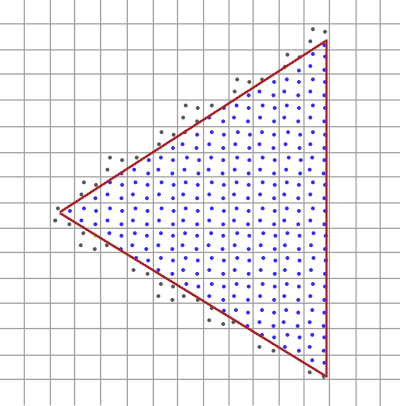

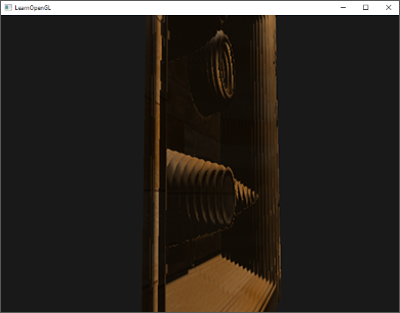

一旦你的顶点坐标已经在顶点着色器中处理过,它们就应该是**标准化设备坐标**了,标准化设备坐标是一个x、y和z值在-1.0到1.0的一小段空间。任何落在范围外的坐标都会被丢弃/裁剪,不会显示在你的屏幕上。下面你会看到我们定义的在标准化设备坐标中的三角形(忽略z轴):

|

||||

|

||||

|

||||

|

||||

与通常的屏幕坐标不同,y轴正方向上的点和(0,0)坐标是这个图像的中心,而不是左上角。最后你希望所有(变换过的)坐标都在这个坐标空间中,否则它们就不可见了。

|

||||

|

||||

你的标准化设备坐标接着会变换为**屏幕空间坐标**(Screen-space Coordinates),这是使用你通过`glViewport`函数提供的数据,进行**视口变换**(Viewport Transform)完成的。最后的屏幕空间坐标被变换为像素输入到片段着色器。

|

||||

|

||||

有了这样的顶点数据,我们会把它作为输入数据发送给图形渲染管线的第一个处理阶段:顶点着色器。它会在GPU上创建储存空间用于储存我们的顶点数据,还要配置OpenGL如何解释这些内存,并且指定如何发送给显卡。顶点着色器接着会处理我们告诉它要处理内存中的顶点的数量。

|

||||

|

||||

我们通过**顶点缓冲对象**(Vertex Buffer Objects, VBO)管理这个内存,它会在GPU内存(通常被称为显存)中储存大批顶点。使用这些缓冲对象的好处是我们可以一次性的发送一大批数据到显卡上,而不是每个顶点发送一次。从CPU把数据发送到显卡相对较慢,所以无论何处我们都要尝试尽量一次性发送尽可能多的数据。当数据到了显卡内存中时,顶点着色器几乎立即就能获得顶点,这非常快。

|

||||

|

||||

顶点缓冲对象(VBO)是我们在OpenGL教程中第一个出现的OpenGL对象。就像OpenGL中的其他对象一样,这个缓冲有一个独一无二的ID,所以我们可以使用`glGenBuffers`函数生成一个缓冲ID:

|

||||

|

||||

```c++

|

||||

GLuint VBO;

|

||||

glGenBuffers(1, &VBO);

|

||||

```

|

||||

|

||||

OpenGL有很多缓冲对象类型,`GL_ARRAY_BUFFER`是其中一个顶点缓冲对象的缓冲类型。OpenGL允许我们同时绑定多个缓冲,只要它们是不同的缓冲类型。我们可以使用`glBindBuffer`函数把新创建的缓冲绑定到`GL_ARRAY_BUFFER`上:

|

||||

|

||||

```c++

|

||||

glBindBuffer(GL_ARRAY_BUFFER, VBO);

|

||||

```

|

||||

|

||||

从这一刻起,我们使用的任何缓冲函数(在`GL_ARRAY_BUFFER`目标上)都会用来配置当前绑定的缓冲(`VBO`)。然后我们可以调用`glBufferData`函数,它会把之前定义的顶点数据复制到缓冲的内存中:

|

||||

|

||||

```c++

|

||||

glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW);

|

||||

```

|

||||

|

||||

`glBufferData`是一个用来把用户定义的数据复制到当前绑定缓冲的函数。它的第一个参数是我们希望把数据复制到上面的缓冲类型:顶点缓冲对象当前绑定到`GL_ARRAY_BUFFER`目标上。第二个参数指定我们希望传递给缓冲的数据的大小(以字节为单位);用一个简单的`sizeof`计算出顶点数据就行。第三个参数是我们希望发送的真实数据。

|

||||

|

||||

第四个参数指定了我们希望显卡如何管理给定的数据。有三种形式:

|

||||

|

||||

- `GL_STATIC_DRAW` :数据不会或几乎不会改变。

|

||||

- `GL_DYNAMIC_DRAW`:数据会被改变很多。

|

||||

- `GL_STREAM_DRAW` :数据每次绘制时都会改变。

|

||||

|

||||

三角形的位置数据不会改变,每次渲染调用时都保持原样,所以它使用的类型最好是`GL_STATIC_DRAW`。如果,比如,一个缓冲中的数据将频繁被改变,那么使用的类型就是`GL_DYNAMIC_DRAW`或`GL_STREAM_DRAW`。这样就能确保图形卡把数据放在高速写入的内存部分。

|

||||

|

||||

现在我们把顶点数据储存在显卡的内存中,用VBO顶点缓冲对象管理。下面我们会创建一个顶点和片段着色器,来处理这些数据。现在我们开始着手创建它们吧。

|

||||

|

||||

## 顶点着色器(Vertex Shader)

|

||||

|

||||

顶点着色器是几个着色器中的一个,它是可编程的。现代OpenGL需要我们至少设置一个顶点和一个片段着色器,如果我们打算做渲染的话。我们会简要介绍一下着色器以及配置两个非常简单的着色器来绘制我们第一个三角形。下个教程里我们会更详细的讨论着色器。

|

||||

|

||||

我们需要做的第一件事是用着色器语言GLSL写顶点着色器,然后编译这个着色器,这样我们就可以在应用中使用它了。下面你会看到一个非常基础的顶点着色器的源代码,它就是使用GLSL写的:

|

||||

|

||||

```c++

|

||||

#version 330 core

|

||||

|

||||

layout (location = 0) in vec3 position;

|

||||

|

||||

void main()

|

||||

{

|

||||

gl_Position = vec4(position.x, position.y, position.z, 1.0);

|

||||

}

|

||||

```

|

||||

|

||||

就像你所看到的那样,GLSL看起来很像C语言。每个着色器都起始于一个版本声明。这是因为OpenGL 3.3和更高的GLSL版本号要去匹配OpenGL的版本(GLSL420版本对应于OpenGL 4.2)。我们同样显式地表示我们会用核心模式(Core-profile)。

|

||||

|

||||

下一步,我们在顶点着色器中声明所有的输入顶点属性,使用in关键字。现在我们只关心位置(Position)数据,所以我们只需要一个顶点属性(Attribute)。GLSL有一个向量数据类型,它包含1到4个`float`元素,包含的数量可以从它的后缀看出来。由于每个顶点都有一个3D坐标,我们就创建一个`vec3`输入变量来表示位置(Position)。我们同样也指定输入变量的位置值(Location),这是用`layout (location = 0)`来完成的,你后面会看到为什么我们会需要这个位置值。

|

||||

|

||||

!!! Important

|

||||

|

||||

**向量(Vector)**

|

||||

|

||||

在图形编程中我们经常会使用向量这个数学概念,因为它简明地表达了任意空间中位置和方向,二者是有用的数学属性。在GLSL中一个向量有最多4个元素,每个元素值都可以从各自代表一个空间坐标的`vec.x`、`vec.y`、`vec.z`和`vec.w`来获取到。注意`vec.w`元素不是用作表达空间中的位置的(我们处理的是3D不是4D)而是用在所谓透视划分(Perspective Division)上。我们会在后面的教程中更详细地讨论向量。

|

||||

|

||||

为了设置顶点着色器的输出,我们必须把位置数据赋值给预定义的`gl_Position`变量,这个位置数据是一个`vec4`类型的。在main函数的最后,无论我们给`gl_Position`设置成什么,它都会成为着色器的输出。由于我们的输入是一个3元素的向量,我们必须把它转换为4元素。我们可以通过把`vec3`数据作为`vec4`初始化构造器的参数,同时把`w`元素设置为`1.0f`(我们会在后面解释为什么)。

|

||||

|

||||

这个顶点着色器可能是能想到的最简单的了,因为我们什么都没有处理就把输入数据输出了。在真实的应用里输入数据通常都没有在标准化设备坐标中,所以我们首先就必须把它们放进OpenGL的可视区域内。

|

||||

|

||||

## 编译一个着色器

|

||||

|

||||

我们已经写了一个顶点着色器源码,但是为了OpenGL能够使用它,我们必须在运行时动态编译它的源码。

|

||||

|

||||

我们要做的第一件事是创建一个着色器对象,再次引用它的ID。所以我们储存这个顶点着色器为`GLuint`,然后用`glCreateShader`创建着色器:

|

||||

|

||||

```c++

|

||||

GLuint vertexShader;

|

||||

vertexShader = glCreateShader(GL_VERTEX_SHADER);

|

||||

```

|

||||

|

||||

我们把着色器的类型提供`glCreateShader`作为它的参数。这里我们传递的参数是`GL_VERTEX_SHADER`这样就创建了一个顶点着色器。

|

||||

|

||||

下一步我们把这个着色器源码附加到着色器对象,然后编译它:

|

||||

|

||||

```c++

|

||||

glShaderSource(vertexShader, 1, &vertexShaderSource, NULL);

|

||||

glCompileShader(vertexShader);

|

||||

```

|

||||

|

||||

`glShaderSource`函数把着色器对象作为第一个参数来编译它。第二参数指定了源码中有多少个**字符串**,这里只有一个。第三个参数是顶点着色器真正的源码,我们可以把第四个参数先设置为`NULL`。

|

||||

|

||||

!!! Important

|

||||

|

||||

你可能会希望检测调用`glCompileShader`后是否编译成功了,是否要去修正错误。检测编译时错误的方法是:

|

||||

|

||||

GLint success;

|

||||

GLchar infoLog[512];

|

||||

glGetShaderiv(vertexShader, GL_COMPILE_STATUS, &success);

|

||||

|

||||

首先我们定义一个整型来表示是否成功编译,还需要一个储存错误消息的容器(如果有的话)。然后我们用`glGetShaderiv`检查是否编译成功了。如果编译失败,我们应该用`glGetShaderInfoLog`获取错误消息,然后打印它。

|

||||

|

||||

if(!success)

|

||||

{

|

||||

glGetShaderInfoLog(vertexShader, 512, NULL, infoLog);

|

||||

std::cout << "ERROR::SHADER::VERTEX::COMPILATION_FAILED\n" << infoLog << std::endl;

|

||||

}

|

||||

|

||||

如果编译的时候没有任何错误,顶点着色器就被编译成功了。

|

||||

|

||||

## 片段着色器(Fragment Shader)

|

||||

|

||||

片段着色器是第二个也是最终我们打算创建的用于渲染三角形的着色器。片段着色器的全部,都是用来计算你的像素的最后颜色输出。为了让事情比较简单,我们的片段着色器只输出橘黄色。

|

||||

|

||||

!!! Important

|

||||

|

||||

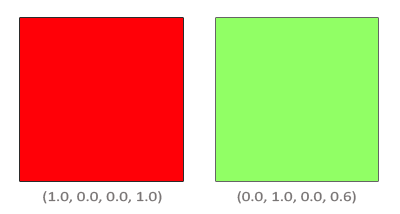

在计算机图形中颜色被表示为有4个元素的数组:红色、绿色、蓝色和alpha(透明度)元素,通常缩写为RGBA。当定义一个OpenGL或GLSL的颜色的时候,我们就把每个颜色的强度设置在0.0到1.0之间。比如,我们设置红色为1.0f,绿色为1.0f,这样这个混合色就是黄色了。这三种颜色元素的不同调配可以生成1600万不同颜色!

|

||||

|

||||

```c++

|

||||

#version 330 core

|

||||

|

||||

out vec4 color;

|

||||

|

||||

void main()

|

||||

{

|

||||

color = vec4(1.0f, 0.5f, 0.2f, 1.0f);

|

||||

}

|

||||

```

|

||||

|

||||

片段着色器只需要一个输出变量,这个变量是一个4元素表示的最终输出颜色的向量,我们可以自己计算出来。我们可以用`out`关键字声明输出变量,这里我们命名为`color`。下面,我们简单的把一个带有alpha值为1.0(1.0代表完全不透明)的橘黄的`vec4`赋值给`color`作为输出。

|

||||

|

||||

编译片段着色器的过程与顶点着色器相似,尽管这次我们使用`GL_FRAGMENT_SHADER`作为着色器类型:

|

||||

|

||||

```c++

|

||||

GLuint fragmentShader;

|

||||

fragmentShader = glCreateShader(GL_FRAGMENT_SHADER);

|

||||

glShaderSource(fragmentShader, 1, &fragmentShaderSource, null);

|

||||

glCompileShader(fragmentShader);

|

||||

```

|

||||

|

||||

每个着色器现在都编译了,剩下的事情是把两个着色器对象链接到一个着色器程序中(Shader Program),它是用来渲染的。

|

||||

|

||||

### 着色器程序

|

||||

|

||||

着色器程序对象(Shader Program Object)是多个着色器最后链接的版本。如果要使用刚才编译的着色器我们必须把它们链接为一个着色器程序对象,然后当渲染物体的时候激活这个着色器程序。激活了的着色器程序的着色器,在调用渲染函数时才可用。

|

||||

|

||||

把着色器链接为一个程序就等于把每个着色器的输出链接到下一个着色器的输入。如果你的输出和输入不匹配那么就会得到一个链接错误。

|

||||

|

||||

创建一个程序对象很简单:

|

||||

|

||||

```c++

|

||||

GLuint shaderProgram;

|

||||

shaderProgram = glCreateProgram();

|

||||

```

|

||||

|

||||

`glCreateProgram`函数创建一个程序,返回新创建的程序对象的ID引用。现在我们需要把前面编译的着色器附加到程序对象上,然后用`glLinkProgram`链接它们:

|

||||

|

||||

```c++

|

||||

glAttachShader(shaderProgram, vertexShader);

|

||||

glAttachShader(shaderProgram, fragmentShader);

|

||||

glLinkProgram(shaderProgram);

|

||||

```

|

||||

|

||||

代码不言自明,我们把着色器附加到程序上,然后用`glLinkProgram`链接。

|

||||

|

||||

!!! Important

|

||||

|

||||

就像着色器的编译一样,我们也可以检验链接着色器程序是否失败,获得相应的日志。与glGetShaderiv和glGetShaderInfoLog不同,现在我们使用:

|

||||

|

||||

glGetProgramiv(shaderProgram, GL_LINK_STATUS, &success);

|

||||

if(!success) {

|

||||

glGetProgramInfoLog(shaderProgram, 512, NULL, infoLog);

|

||||

...

|

||||

}

|

||||

|

||||

我们可以调用`glUseProgram`函数,用新创建的程序对象作为它的参数,这样就能激活这个程序对象:

|

||||

|

||||

```c++

|

||||

glUseProgram(shaderProgram);

|

||||

```

|

||||

|

||||

现在在`glUseProgram`函数调用之后的每个着色器和渲染函数都会用到这个程序对象(当然还有这些链接的着色器)了。

|

||||

|

||||

在我们把着色器对象链接到程序对象以后,不要忘记删除着色器对象;我们不再需要它们了:

|

||||

|

||||

```c++

|

||||

glDeleteShader(vertexShader);

|

||||

glDeleteShader(fragmentShader);

|

||||

```

|

||||

|

||||

现在,我们把输入顶点数据发送给GPU,指示GPU如何在顶点和片段着色器中处理它。还没结束,OpenGL还不知道如何解释内存中的顶点数据,以及怎样把顶点数据链接到顶点着色器的属性上。我们需要告诉OpenGL怎么做。

|

||||

|

||||

## 链接顶点属性

|

||||

|

||||

顶点着色器允许我们以任何我们想要的形式作为顶点属性(Vertex Attribute)的输入,同样它也具有很强的灵活性,这意味着我们必须手动指定我们的输入数据的哪一个部分对应顶点着色器的哪一个顶点属性。这意味着我们必须在渲染前指定OpenGL如何解释顶点数据。

|

||||

|

||||

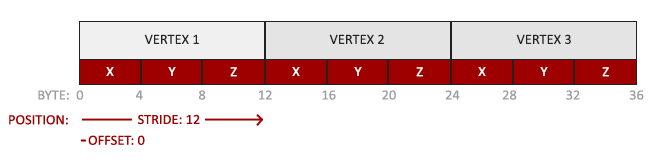

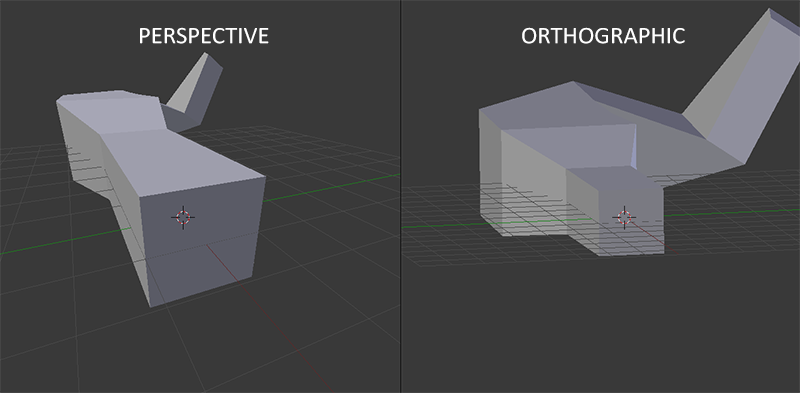

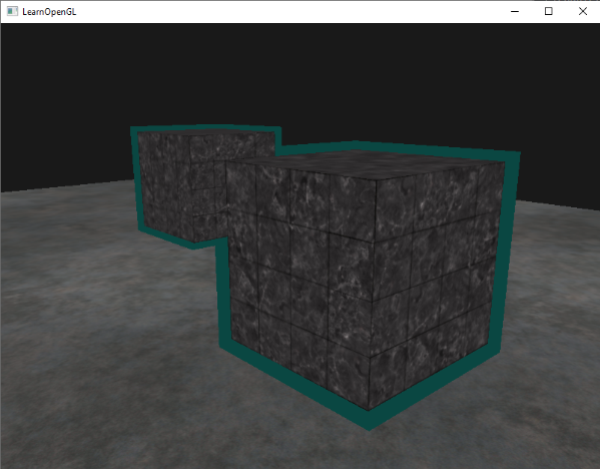

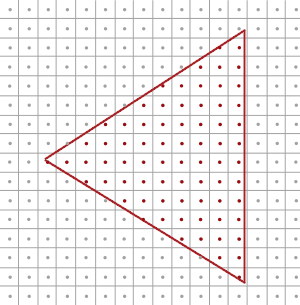

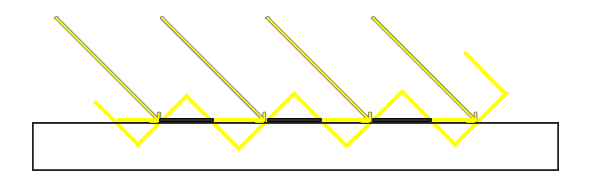

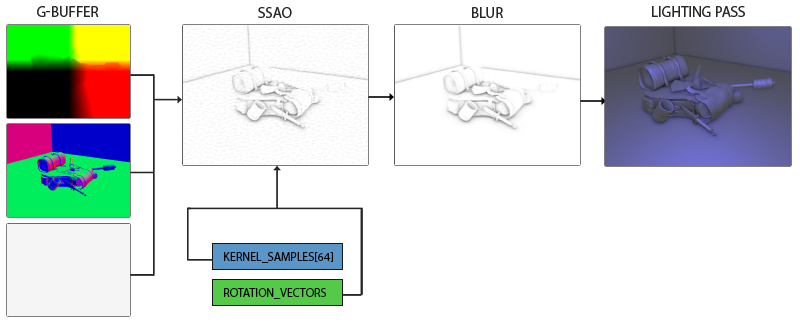

我们的顶点缓冲数据被格式化为下面的形式:

|

||||

|

||||

|

||||

|

||||

- 位置数据被储存为32-bit(4 byte)浮点值。

|

||||

- 每个位置包含3个这样的值。

|

||||

- 在这3个值之间没有空隙(或其他值)。这几个值紧密排列为一个数组。

|

||||

- 数据中第一个值是缓冲的开始位置。

|

||||

|

||||

有了这些信息我们就可以告诉OpenGL如何解释顶点数据了(每一个顶点属性),我们使用`glVertexAttribPointer`这个函数:

|

||||

|

||||

```c++

|

||||

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(GLfloat), (GLvoid*)0);

|

||||

glEnableVertexAttribArray(0);

|

||||

```

|

||||

|

||||

`glVertexAttribPointer`函数有很多参数,所以我们仔细来了解它们:

|

||||

|

||||

- 第一个参数指定我们要配置哪一个顶点属性。记住,我们在顶点着色器中使用`layout(location = 0)`定义了顶点属性——位置(Position)的位置值(Location)。这样要把顶点属性的位置值(Location)设置为0,因为我们希望把数据传递到这个顶点属性中,所以我们在这里填0。

|

||||

- 第二个参数指定顶点属性的大小。顶点属性是`vec3`类型,它由3个数值组成。

|

||||

- 第三个参数指定数据的类型,这里是`GL_FLOAT`(GLSL中`vec*`是由浮点数组成的)。

|

||||

- 下个参数定义我们是否希望数据被标准化。如果我们设置为`GL_TRUE`,所有数据都会被映射到0(对于有符号型signed数据是-1)到1之间。我们把它设置为`GL_FALSE`。

|

||||

- 第五个参数叫做步长(Stride),它告诉我们在连续的顶点属性之间间隔有多少。由于下个位置数据在3个`GLfloat`后面的位置,我们把步长设置为`3 * sizeof(GLfloat)`。要注意的是由于我们知道这个数组是紧密排列的(在两个顶点属性之间没有空隙)我们也可以设置为0来让OpenGL决定具体步长是多少(只有当数值是紧密排列时才可用)。每当我们有更多的顶点属性,我们就必须小心地定义每个顶点属性之间的空间,我们在后面会看到更多的例子(译注: 这个参数的意思简单说就是从这个属性第二次出现的地方到整个数组0位置之间有多少字节)。

|

||||

- 最后一个参数有奇怪的`GLvoid*`的强制类型转换。它表示我们的位置数据在缓冲中起始位置的偏移量。由于位置数据是数组的开始,所以这里是0。我们会在后面详细解释这个参数。

|

||||

|

||||

!!! Important

|

||||

|

||||

每个顶点属性从VBO管理的内存中获得它的数据,它所获取数据的那个VBO,就是当调用`glVetexAttribPointer`的时候,最近绑定到`GL_ARRAY_BUFFER`的那个VBO。由于在调用`glVertexAttribPointer`之前绑定了VBO,顶点属性0现在链接到了它的顶点数据。

|

||||

|

||||

现在我们定义OpenGL如何解释顶点数据,我们也要开启顶点属性,使用`glEnableVertexAttribArray`,把顶点属性位置值作为它的参数;顶点属性默认是关闭的。自此,我们把每件事都做好了:我们使用一个顶点缓冲对象初始化了一个缓冲中的顶点数据,设置了一个顶点和片段着色器,告诉了OpenGL如何把顶点数据链接到顶点着色器的顶点属性上。在OpenGL绘制一个物体,看起来会像是这样:

|

||||

|

||||

```c++

|

||||

// 0. 复制顶点数组到缓冲中提供给OpenGL使用

|

||||

glBindBuffer(GL_ARRAY_BUFFER, VBO);

|

||||

glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW);

|

||||

// 1. 设置顶点属性指针

|

||||

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(GLfloat), (GLvoid*)0);

|

||||

glEnableVertexAttribArray(0);

|

||||

// 2. 当我们打算渲染一个物体时要使用着色器程序

|

||||

glUseProgram(shaderProgram);

|

||||

// 3. 绘制物体

|

||||

someOpenGLFunctionThatDrawsOurTriangle();

|

||||

```

|

||||

|

||||

我们绘制一个物体的时候必须重复这件事。这看起来也不多,但是如果有超过5个顶点属性,100多个不同物体呢(这其实并不罕见)。绑定合适的缓冲对象,为每个物体配置所有顶点属性很快就变成一件麻烦事。有没有一些方法可以使我们把所有的配置储存在一个对象中,并且可以通过绑定这个对象来恢复状态?

|

||||

|

||||

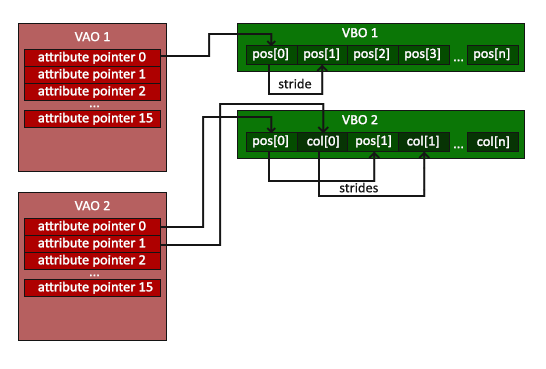

### 顶点数组对象(Vertex Array Object, VAO)

|

||||

|

||||

**顶点数组对象(Vertex Array Object, VAO)**可以像顶点缓冲对象一样绑定,任何随后的顶点属性调用都会储存在这个VAO中。这有一个好处,当配置顶点属性指针时,你只用做一次,每次绘制一个物体的时候,我们绑定相应VAO就行了。切换不同顶点数据和属性配置就像绑定一个不同的VAO一样简单。所有状态我们都放到了VAO里。

|

||||

|

||||

!!! Attention

|

||||

|

||||

OpenGL核心模式版要求我们使用VAO,这样它就能知道对我们的顶点输入做些什么。如果我们绑定VAO失败,OpenGL会拒绝绘制任何东西。

|

||||

|

||||

一个顶点数组对象储存下面的内容:

|

||||

|

||||

- 调用`glEnableVertexAttribArray`和`glDisableVertexAttribArray`。

|

||||

- 使用`glVertexAttribPointer`的顶点属性配置。

|

||||

- 使用`glVertexAttribPointer`进行的顶点缓冲对象与顶点属性链接。

|

||||

|

||||

|

||||

|

||||

生成一个VAO和生成VBO类似:

|

||||

|

||||

```c++

|

||||

GLuint VAO;

|

||||

glGenVertexArrays(1, &VAO);

|

||||

```

|

||||

|

||||

使用VAO要做的全部就是使用`glBindVertexArray`绑定VAO。自此我们就应该绑定/配置相应的VBO和属性指针,然后解绑VAO以备后用。当我们打算绘制一个物体的时候,我们只要在绘制物体前简单地把VAO绑定到希望用到的配置就行了。这段代码应该看起来像这样:

|

||||

|

||||

```c++

|

||||

// ..:: 初始化代码 (一次完成 (除非你的物体频繁改变)) :: ..

|

||||

|

||||

// 1. 绑定VAO

|

||||

glBindVertexArray(VAO);

|

||||

|

||||

// 2. 把顶点数组复制到缓冲中提供给OpenGL使用

|

||||

glBindBuffer(GL_ARRAY_BUFFER, VBO);

|

||||

glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW);

|

||||

|

||||

// 3. 设置顶点属性指针

|

||||

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(GLfloat), (GLvoid * )0);

|

||||

glEnableVertexAttribArray(0);

|

||||

|

||||

//4. 解绑VAO

|

||||

glBindVertexArray(0);

|

||||

|

||||

[...]

|

||||

|

||||

// ..:: 绘制代码 (in Game loop) :: ..

|

||||

|

||||

// 5. 绘制物体

|

||||

glUseProgram(shaderProgram);

|

||||

glBindVertexArray(VAO);

|

||||

someOpenGLFunctionThatDrawsOurTriangle();

|

||||

glBindVertexArray(0);

|

||||

```

|

||||

|

||||

!!! Attention

|

||||

|

||||

通常情况下当我们配置好它们以后要解绑OpenGL对象,这样我们才不会在某处错误地配置它们。

|

||||

|

||||

就是现在!前面做的一切都是等待这一刻,我们已经把我们的顶点属性配置和打算使用的VBO储存到一个VAO中。一般当你有多个物体打算绘制时,你首先要生成/配置所有的VAO(它需要VBO和属性指针),然后储存它们准备后面使用。当我们打算绘制物体的时候就拿出相应的VAO,绑定它,绘制完物体后,再解绑VAO。

|

||||

|

||||

### 我们一直期待的三角形

|

||||

|

||||

OpenGL的`glDrawArrays`函数为我们提供了绘制物体的能力,它使用当前激活的着色器、前面定义的顶点属性配置和VBO的顶点数据(通过VAO间接绑定)来绘制基本图形。

|

||||

|

||||

```c++

|

||||

glUseProgram(shaderProgram);

|

||||

glBindVertexArray(VAO);

|

||||

glDrawArrays(GL_TRIANGLES, 0, 3);

|

||||

glBindVertexArray(0);

|

||||

```

|

||||

|

||||

`glDrawArrays`函数第一个参数是我们打算绘制的OpenGL基本图形的类型。由于我们在一开始时说过,我们希望绘制三角形,我们传递`GL_TRIANGLES`给它。第二个参数定义了我们打算绘制的那个顶点数组的起始位置的索引;我们这里填0。最后一个参数指定我们打算绘制多少个顶点,这里是3(我们只从我们的数据渲染一个三角形,它只有3个顶点)。

|

||||

|

||||

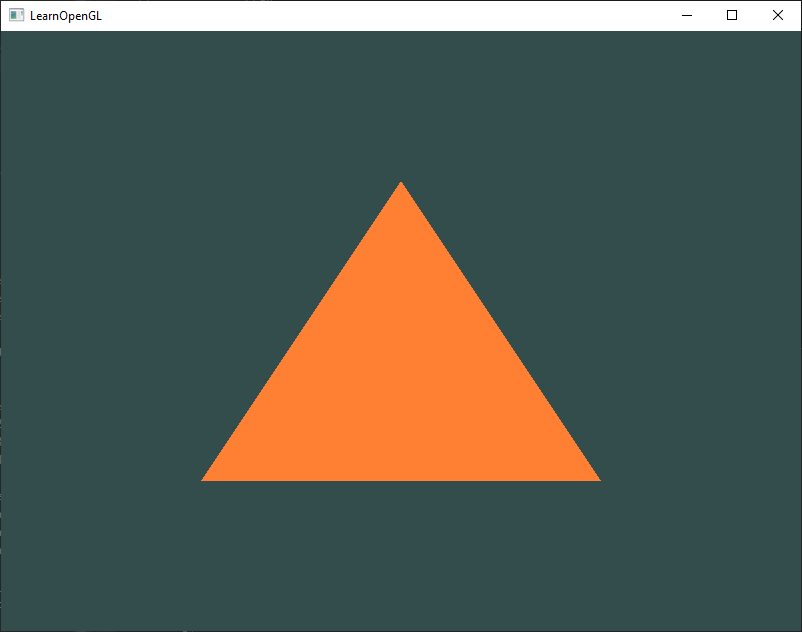

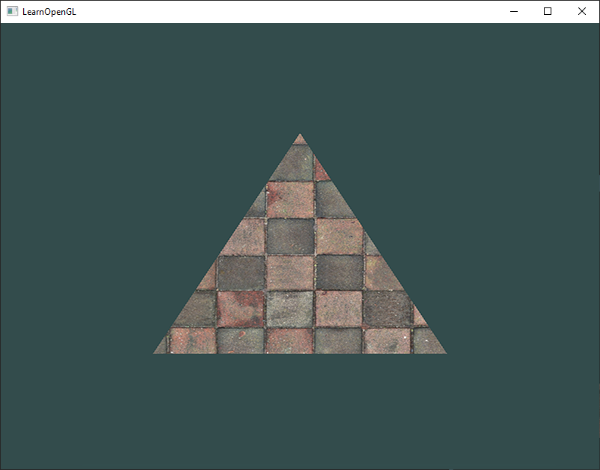

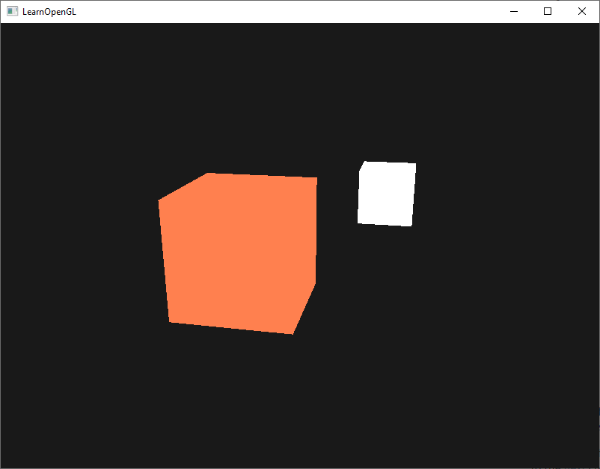

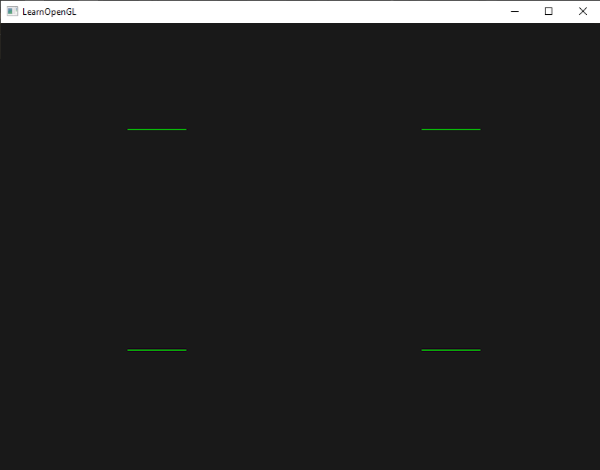

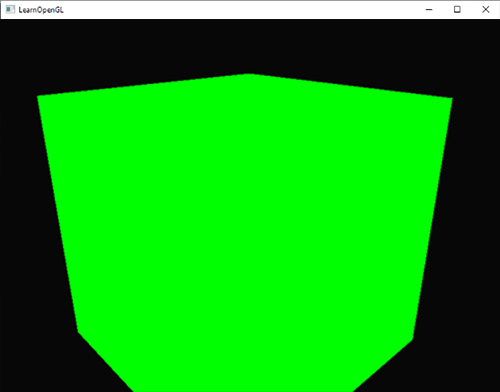

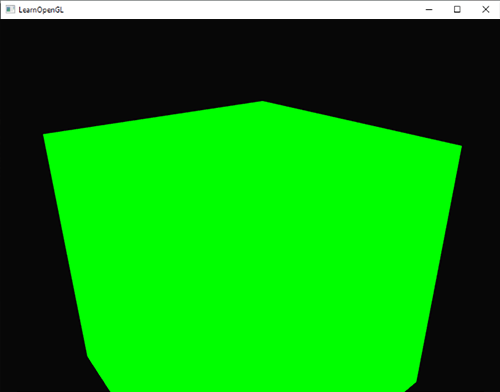

现在尝试编译代码,如果弹出了任何错误,回头检查你的代码。如果你编译通过了,你应该看到下面的结果:

|

||||

|

||||

|

||||

|

||||

完整的程序源码可以在[这里](http://learnopengl.com/code_viewer.php?code=getting-started/hellotriangle)找到。

|

||||

|

||||

如果你的输出和这个不一样,你可能做错了什么,去看源码,看看是否遗漏了什么东西或者在评论部分提问。

|

||||

|

||||

## 索引缓冲对象(Element Buffer Objects,EBO)

|

||||

|

||||

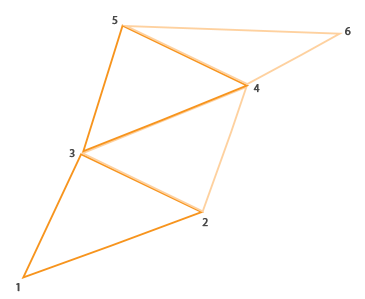

这是我们最后一件在渲染顶点这个问题上要讨论的事——索引缓冲对象简称EBO(或IBO)。解释索引缓冲对象的工作方式最好是举例子:假设我们不再绘制一个三角形而是矩形。我们就可以绘制两个三角形来组成一个矩形(OpenGL主要就是绘制三角形)。这会生成下面的顶点的集合:

|

||||

|

||||

```c++

|

||||

GLfloat vertices[] = {

|

||||

|

||||

// 第一个三角形

|

||||

0.5f, 0.5f, 0.0f, // 右上角

|

||||

0.5f, -0.5f, 0.0f, // 右下角

|

||||

-0.5f, 0.5f, 0.0f, // 左上角

|

||||

|

||||

// 第二个三角形

|

||||

0.5f, -0.5f, 0.0f, // 右下角

|

||||

-0.5f, -0.5f, 0.0f, // 左下角

|

||||

-0.5f, 0.5f, 0.0f // 左上角

|

||||

};

|

||||

```

|

||||

|

||||

就像你所看到的那样,有几个顶点叠加了。我们指定右下角和左上角两次!一个矩形只有4个而不是6个顶点,这样就产生50%的额外开销。当我们有超过1000个三角的模型这个问题会更糟糕,这会产生一大堆浪费。最好的解决方案就是每个顶点只储存一次,当我们打算绘制这些顶点的时候只调用顶点的索引。这种情况我们只要储存4个顶点就能绘制矩形了,我们只要指定我们打算绘制的那个顶点的索引就行了。如果OpenGL提供这个功能就好了,对吧?

|

||||

|

||||

很幸运,索引缓冲的工作方式正是这样的。一个EBO是一个像顶点缓冲对象(VBO)一样的缓冲,它专门储存索引,OpenGL调用这些顶点的索引来绘制。索引绘制正是这个问题的解决方案。我们先要定义(独一无二的)顶点,和绘制出矩形的索引:

|

||||

|

||||

```c++

|

||||

GLfloat vertices[] = {

|

||||

|

||||

0.5f, 0.5f, 0.0f, // 右上角

|

||||

0.5f, -0.5f, 0.0f, // 右下角

|

||||

-0.5f, -0.5f, 0.0f, // 左下角

|

||||

-0.5f, 0.5f, 0.0f // 左上角

|

||||

};

|

||||

|

||||

GLuint indices[] = { // 起始于0!

|

||||

|

||||

0, 1, 3, // 第一个三角形

|

||||

1, 2, 3 // 第二个三角形

|

||||

};

|

||||

```

|

||||

|

||||

你可以看到,当时用索引的时候,我们只定义了4个顶点,而不是6个。下一步我们需要创建索引缓冲对象:

|

||||

|

||||

```c++

|

||||

GLuint EBO;

|

||||

glGenBuffers(1, &EBO);

|

||||

```

|

||||

|

||||

与VBO相似,我们绑定EBO然后用`glBufferData`把索引复制到缓冲里。同样,和VBO相似,我们会把这些函数调用放在绑定和解绑函数调用之间,这次我们把缓冲的类型定义为`GL_ELEMENT_ARRAY_BUFFER`。

|

||||

|

||||

```c++

|

||||

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, EBO);

|

||||

glBufferData(GL_ELEMENT_ARRAY_BUFFER, sizeof(indices), indices, GL_STATIC_DRAW);

|

||||

```

|

||||

|

||||

要注意的是,我们现在用`GL_ELEMENT_ARRAY_BUFFER`当作缓冲目标。最后一件要做的事是用`glDrawElements`来替换`glDrawArrays`函数,来指明我们从索引缓冲渲染。当时用`glDrawElements`的时候,我们就会用当前绑定的索引缓冲进行绘制:

|

||||

|

||||

```c++

|

||||

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, EBO);

|

||||

glDrawElements(GL_TRIANGLES, 6, GL_UNSIGNED_INT, 0);

|

||||

```

|

||||

|

||||

第一个参数指定了我们绘制的模式,这个和`glDrawArrays`的一样。第二个参数是我们打算绘制顶点的次数。我们填6,说明我们总共想绘制6个顶点。第三个参数是索引的类型,这里是`GL_UNSIGNED_INT`。最后一个参数里我们可以指定EBO中的偏移量(或者传递一个索引数组,但是这只是当你不是在使用索引缓冲对象的时候),但是我们只打算在这里填写0。

|

||||

|

||||

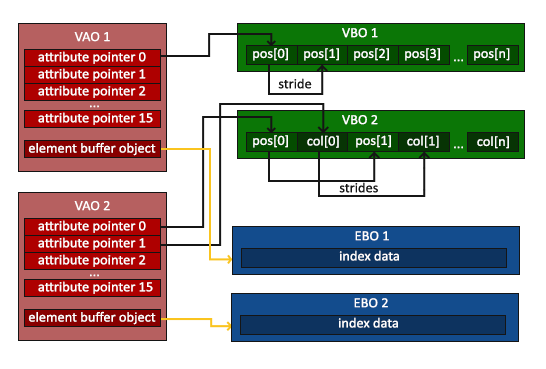

`glDrawElements`函数从当前绑定到`GL_ELEMENT_ARRAY_BUFFER`目标的EBO获取索引。这意味着我们必须在每次要用索引渲染一个物体时绑定相应的EBO,这还是有点麻烦。不过顶点数组对象仍可以保存索引缓冲对象的绑定状态。VAO绑定之后可以索引缓冲对象,EBO就成为了VAO的索引缓冲对象。再次绑定VAO的同时也会自动绑定EBO。

|

||||

|

||||

|

||||

|

||||

!!! Attention

|

||||

|

||||

当目标是`GL_ELEMENT_ARRAY_BUFFER`的时候,VAO储存了`glBindBuffer`的函数调用。这也意味着它也会储存解绑调用,所以确保你没有在解绑VAO之前解绑索引数组缓冲,否则就没有这个EBO配置了。

|

||||

|

||||

最后的初始化和绘制代码现在看起来像这样:

|

||||

|

||||

```c++

|

||||

// ..:: 初始化代码 :: ..

|

||||

// 1. 绑定VAO

|

||||

glBindVertexArray(VAO);

|

||||

|

||||

// 2. 把我们的顶点数组复制到一个顶点缓冲中,提供给OpenGL使用

|

||||

glBindBuffer(GL_ARRAY_BUFFER, VBO);

|

||||

glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW);

|

||||

|

||||

// 3. 复制我们的索引数组到一个索引缓冲中,提供给OpenGL使用

|

||||

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, EBO);

|

||||

glBufferData(GL_ELEMENT_ARRAY_BUFFER, sizeof(indices),indices, GL_STATIC_DRAW);

|

||||

|

||||

// 3. 设置顶点属性指针

|

||||

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(GLfloat), (GLvoid * )0);

|

||||

glEnableVertexAttribArray(0);

|

||||

|

||||

// 4. 解绑VAO,不解绑EBO(译注:解绑缓冲相当于没有绑定缓冲,可以在解绑VAO之后解绑缓冲)

|

||||

glBindVertexArray(0);

|

||||

|

||||

[...]

|

||||

|

||||

// ..:: 绘制代码(在游戏循环中) :: ..

|

||||

|

||||

glUseProgram(shaderProgram);

|

||||

glBindVertexArray(VAO);

|

||||

glDrawElements(GL_TRIANGLES, 6, GL_UNSIGNED_INT, 0)

|

||||

glBindVertexArray(0);

|

||||

```

|

||||

|

||||

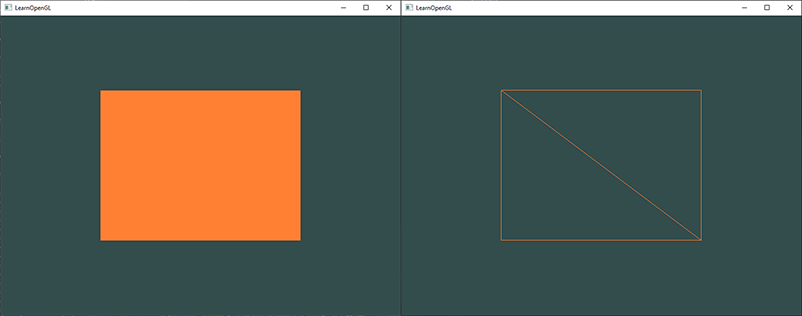

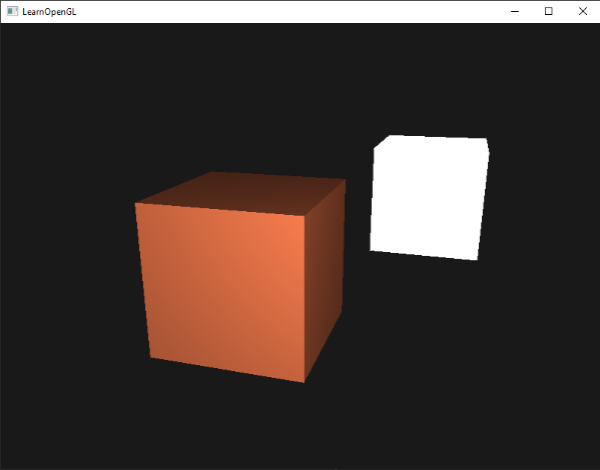

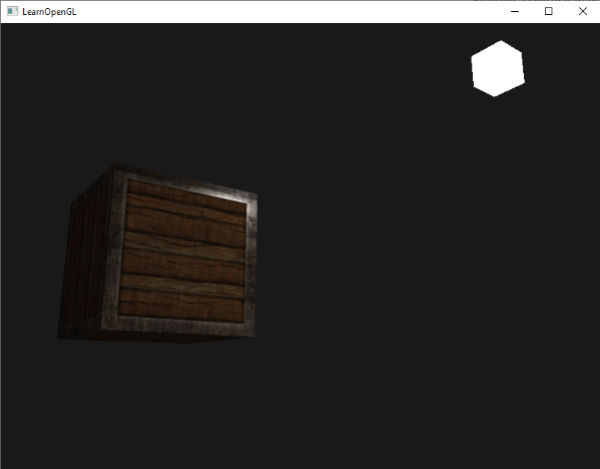

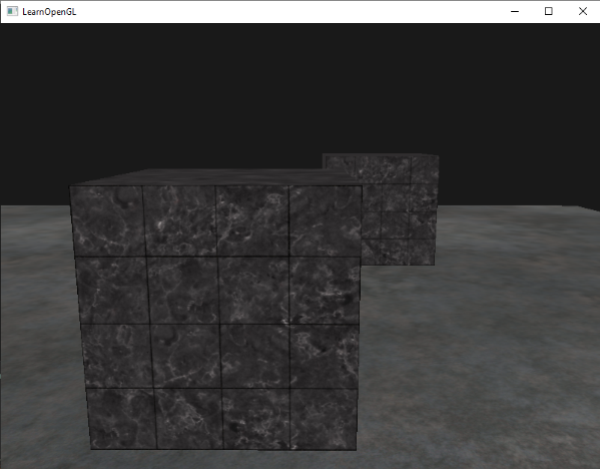

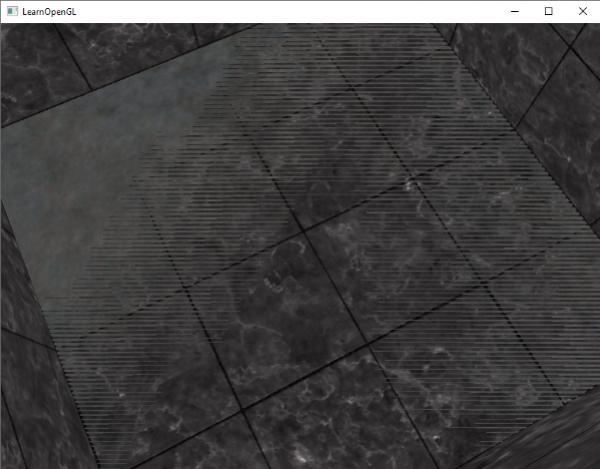

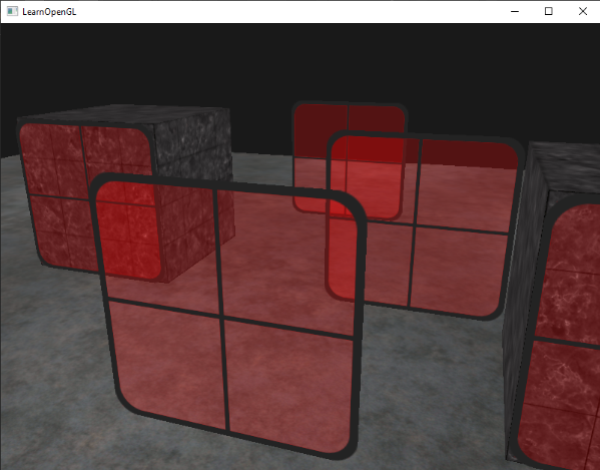

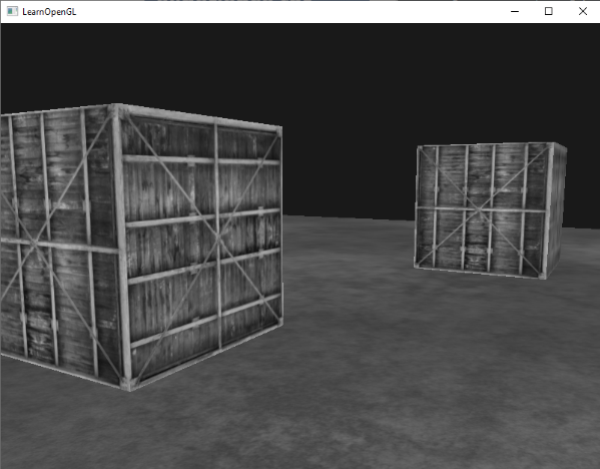

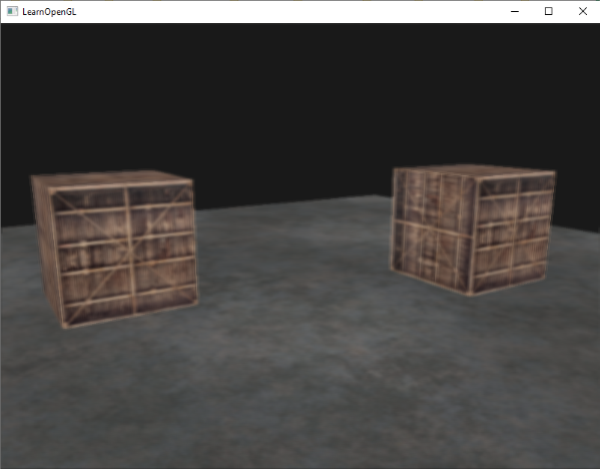

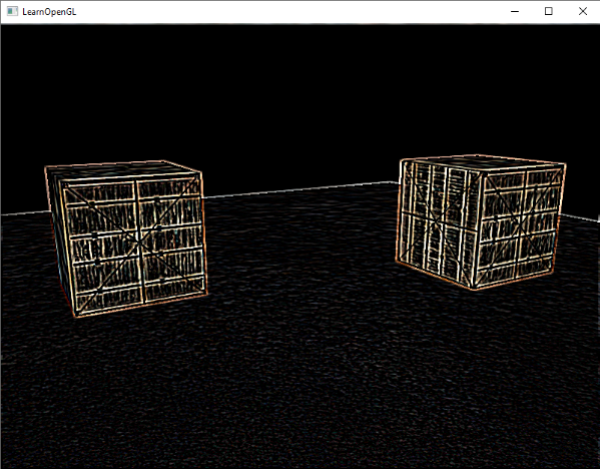

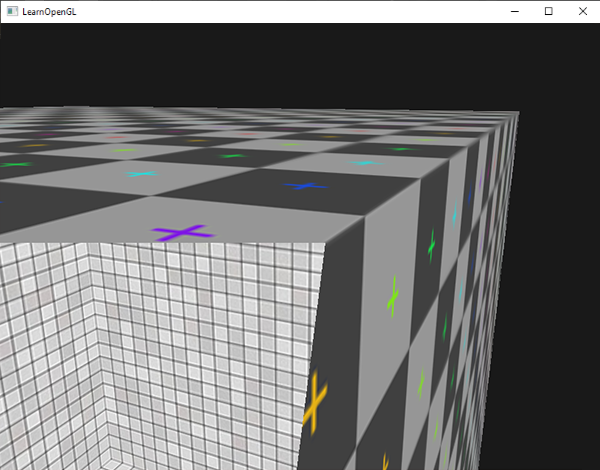

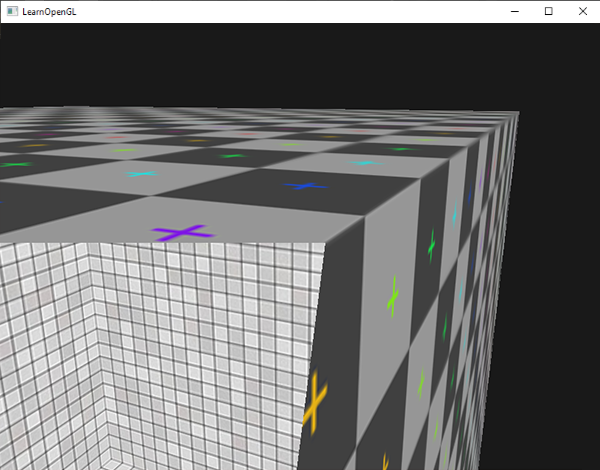

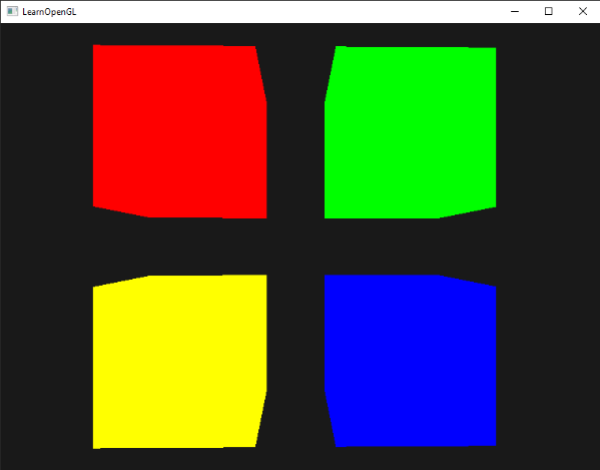

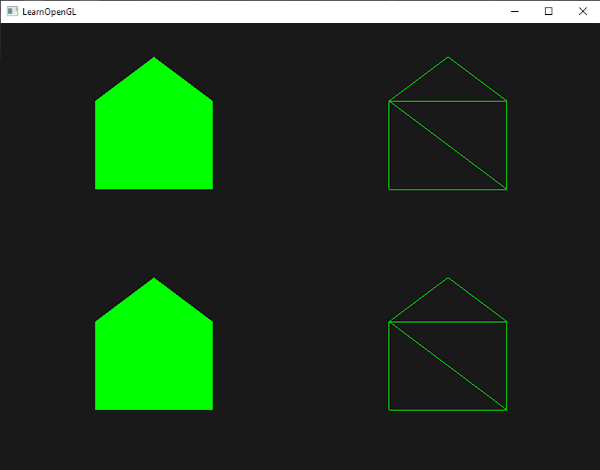

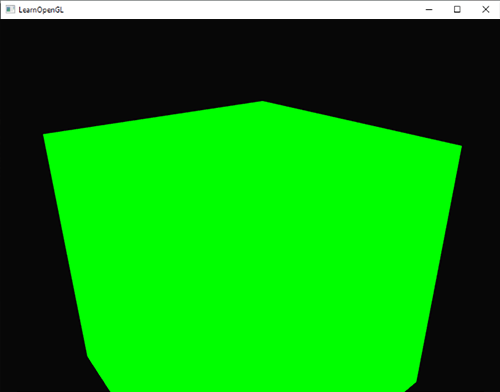

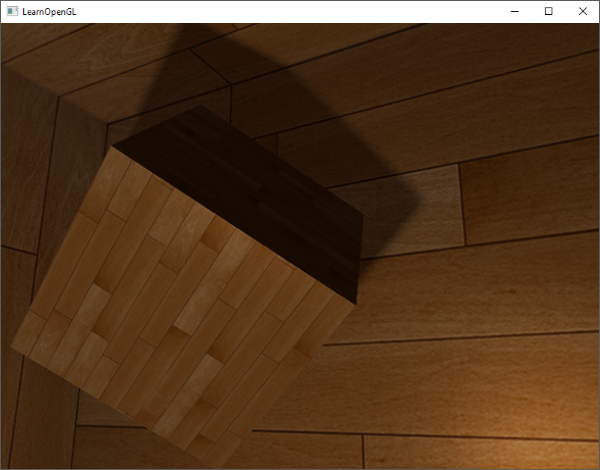

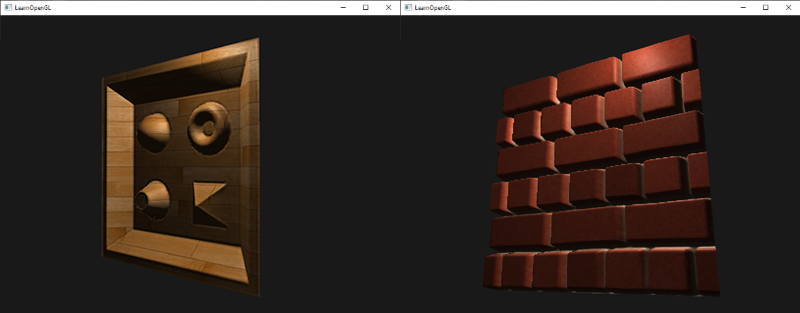

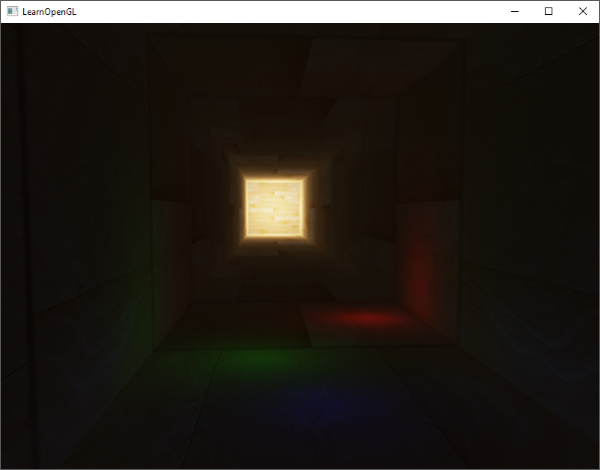

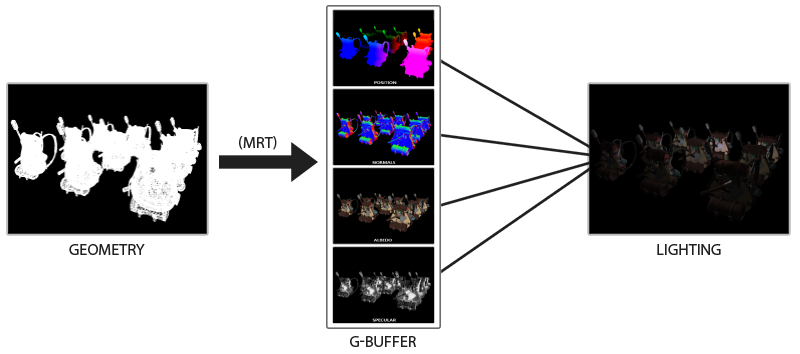

运行程序会获得下面这样的图片的结果。左侧图片看起来很熟悉,而右侧的则是使用线框模式(Wireframe Mode)绘制的。线框矩形可以显示出矩形的确是由两个三角形组成的。

|

||||

|

||||

|

||||

|

||||

!!! Important

|

||||

|

||||

**线框模式(Wireframe Mode)**

|

||||

|

||||

如果用线框模式绘制你的三角,你可以配置OpenGL绘制用的基本图形,调用`glPolygonMode(GL_FRONT_AND_BACK, GL_LINE)`。第一个参数说:我们打算应用到所有的三角形的前面和背面,第二个参数告诉我们用线来绘制。在随后的绘制函数调用后会一直以线框模式绘制三角形,直到我们用`glPolygonMode(GL_FRONT_AND_BACK, GL_FILL)`设置回了默认模式。

|

||||

|

||||

如果你遇到任何错误,回头检查代码,看看是否遗漏了什么。同时,你可以[在这里获得全部源码](http://learnopengl.com/code_viewer.php?code=getting-started/hellotriangle2),也可以在评论区自由提问。

|

||||

|

||||

如果你绘制出了这个三角形或矩形,那么恭喜你,你成功地通过了现代OpenGL最难部分之一:绘制你自己的第一个三角形。这部分很难,因为在可以绘制第一个三角形之前需要很多知识。幸运的是我们现在已经越过了这个障碍,接下来的教程会比较容易理解一些。

|

||||

|

||||

## 附加资源

|

||||

|

||||

- [antongerdelan.net/hellotriangle](http://antongerdelan.net/opengl/hellotriangle.html): 一个渲染第一个三角形的教程。

|

||||

- [open.gl/drawing](https://open.gl/drawing): Alexander Overvoorde的关于渲染第一个三角形的教程。

|

||||

- [antongerdelan.net/vertexbuffers](http://antongerdelan.net/opengl/vertexbuffers.html): 顶点缓冲对象的一些深入探讨。

|

||||

|

||||

# 练习

|

||||

|

||||

为了更好的理解讨论的那些概念最好做点练习。建议在继续下面的主题之前做完这些练习,确保你对这些有比较好的理解。

|

||||

|

||||

- 尝试使用`glDrawArrays`以在你的数据中添加更多顶点的方式,绘制两个彼此相连的三角形:[参考解答](http://learnopengl.com/code_viewer.php?code=getting-started/hello-triangle-exercise1)

|

||||

- 现在,使用不同的VAO(和VBO)创建同样的2个三角形,每个三角形的数据要不同(提示:创建2个顶点数据数组,而不是1个):[参考解答](http://learnopengl.com/code_viewer.php?code=getting-started/hello-triangle-exercise2)

|

||||

- 创建两个着色器程序(Shader Program),第二个程序使用不同的片段着色器,它输出黄色;绘制这两个三角形,其中一个输出为黄色:[参考解答](http://learnopengl.com/code_viewer.php?code=getting-started/hello-triangle-exercise3)

|

||||

@@ -1,448 +0,0 @@

|

||||

# 着色器(Shader)

|

||||

|

||||

原文 | [Shaders](http://learnopengl.com/#!Getting-started/Shaders)

|

||||

---|---

|

||||

作者 | JoeyDeVries

|

||||

翻译 | [Django](http://bullteacher.com/)

|

||||

校对 | Geequlim

|

||||

|

||||

在[Hello Triangle](http://learnopengl-cn.readthedocs.org/zh/latest/01%20Getting%20started/04%20Hello%20Triangle/)教程中提到,着色器是运行在GPU上的小程序。这些小程序为图形渲染管线的一个特定部分而运行。从基本意义上来说,着色器不是别的,只是一种把输入转化为输出的程序。着色器也是一种相当独立的程序,它们不能相互通信;只能通过输入和输出的方式来进行沟通。

|

||||

|

||||

前面的教程里我们简要地触及了一点着色器的皮毛。了解了如何恰当地使用它们。现在我们会用一种更加通用的方式详细解释着色器,特别是OpenGL着色器语言。

|

||||

|

||||

## GLSL

|

||||

|

||||

着色器是使用一种叫GLSL的类C语言写成的。GLSL是为图形计算量身定制的,它包含针对向量和矩阵操作的有用特性。

|

||||

|

||||

着色器的开头总是要声明版本,接着是输入和输出变量、uniform和`main`函数。每个着色器的入口都是`main`函数,在这里我们处理所有输入变量,用输出变量输出结果。如果你不知道什么是uniform也不用担心,我们后面会进行讲解。

|

||||

|

||||

一个典型的着色器有下面的结构:

|

||||

|

||||

```c++

|

||||

#version version_number

|

||||

|

||||

in type in_variable_name;

|

||||

in type in_variable_name;

|

||||

|

||||

out type out_variable_name;

|

||||

|

||||

uniform type uniform_name;

|

||||

|

||||

int main()

|

||||

{

|

||||

// 处理输入

|

||||

...

|

||||

// 输出

|

||||

out_variable_name = weird_stuff_we_processed;

|

||||

}

|

||||

```

|

||||

|

||||

当我们谈论特别是谈到顶点着色器的时候,每个输入变量也叫顶点属性(Vertex Attribute)。能声明多少个顶点属性是由硬件决定的。OpenGL确保至少有16个包含4个元素的顶点属性可用,但是有些硬件或许可用更多,你可以查询`GL_MAX_VERTEX_ATTRIB`S来获取这个数目。

|

||||

|

||||

```c++

|

||||

GLint nrAttributes;

|

||||

glGetIntegerv(GL_MAX_VERTEX_ATTRIBS, &nrAttributes);

|

||||

std::cout << "Maximum nr of vertex attributes supported: " << nrAttributes << std::endl;

|

||||

```

|

||||

|

||||

通常情况下它会返回至少16个,大部分情况下是够用了。

|

||||

|

||||

## 数据类型

|

||||

|

||||

GLSL有像其他编程语言相似的数据类型。GLSL有C风格的默认基础数据类型:`int`、`float`、`double`、`uint`和`bool`。GLSL也有两种容器类型,教程中我们会使用很多,它们是向量(Vector)和矩阵(Matrix),其中矩阵我们会在之后的教程里再讨论。

|

||||

|

||||

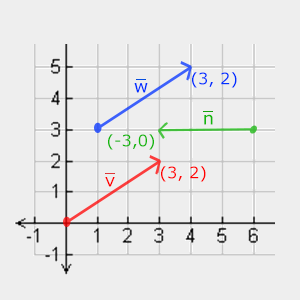

## 向量(Vector)

|

||||

|

||||

GLSL中的向量可以包含有1、2、3或者4个分量,分量类型可以是前面默认基础类型的任意一个。它们可以是下面的形式(n代表元素数量):

|

||||

|

||||

类型|含义

|

||||

---|---

|

||||

vecn | 包含n个默认为float元素的向量

|

||||

bvecn| 包含n个布尔元素向量

|

||||

ivecn| 包含n个int元素的向量

|

||||

uvecn| 包含n个unsigned int元素的向量

|

||||

dvecn| 包含n个double元素的向量

|

||||

|

||||

大多数时候我们使用vecn,因为float足够满足大多数要求。

|

||||

|

||||

一个向量的元素可以通过`vec.x`这种方式获取,这里`x`是指这个向量的第一个元素。你可以分别使用`.x`、`.y`、`.z`和`.w`来获取它们的第1、2、3、4号元素。GLSL也允许你使用**rgba**来获取颜色的元素,或是**stpq**获取纹理坐标元素。

|

||||

|

||||

向量的数据类型也允许一些有趣而灵活的元素选择方式,叫做重组(Swizzling)。重组允许这样的语法:

|

||||

|

||||

```c++

|

||||

vec2 someVec;

|

||||

vec4 differentVec = someVec.xyxx;

|

||||

vec3 anotherVec = differentVec.zyw;

|

||||

vec4 otherVec = someVec.xxxx + anotherVec.yxzy;

|

||||

```

|

||||

|

||||

你可以使用上面任何4个字母组合来创建一个新的和原来向量一样长的向量(但4个元素需要是同一种类型);不允许在一个vec2向量中去获取.z元素。我们可以把一个向量作为一个参数传给不同的向量构造函数,以减少参数需求的数量:

|

||||

|

||||

```c++

|

||||

vec2 vect = vec2(0.5f, 0.7f);

|

||||

vec4 result = vec4(vect, 0.0f, 0.0f);

|

||||

vec4 otherResult = vec4(result.xyz, 1.0f);

|

||||

```

|

||||

|

||||

向量是一种灵活的数据类型,我们可以把用在所有输入和输出上。学完教程你会看到很多如何创造性地管理向量的例子。

|

||||

|

||||

## 输入与输出(in vs out)

|

||||

|

||||

着色器是各自独立的小程序,但是它们都是一个整体的局部,出于这样的原因,我们希望每个着色器都有输入和输出,这样才能进行数据交流和传递。GLSL定义了`in`和`out`关键字来实现这个目的。每个着色器使用这些关键字定义输入和输出,无论在哪儿,一个输出变量就能与一个下一个阶段的输入变量相匹配。他们在顶点和片段着色器之间有点不同。

|

||||

|

||||

顶点着色器应该接收的输入是一种特有形式,否则就会效率低下。顶点着色器的输入是特殊的,它所接受的是从顶点数据直接输入的。为了定义顶点数据被如何组织,我们使用`location`元数据指定输入变量,这样我们才可以在CPU上配置顶点属性。我们已经在前面的教程看过`layout (location = 0)`。顶点着色器需要为它的输入提供一个额外的`layout`定义,这样我们才能把它链接到顶点数据。

|

||||

|

||||

!!! Important

|

||||

|

||||

也可以移除`layout (location = 0)`,通过在OpenGL代码中使用`glGetAttribLocation`请求属性地址(Location),但是我更喜欢在着色器中设置它们,理解容易而且节省时间。

|

||||

|

||||

另一个例外是片段着色器需要一个`vec4`颜色输出变量,因为片段着色器需要生成一个最终输出的颜色。如果你在片段着色器没有定义输出颜色,OpenGL会把你的物体渲染为黑色(或白色)。

|

||||

|

||||

所以,如果我们打算从一个着色器向另一个着色器发送数据,我们必须**在发送方着色器中声明一个输出,在接收方着色器中声明一个同名输入**。当名字和类型都一样的时候,OpenGL就会把两个变量链接到一起,它们之间就能发送数据了(这是在链接程序(Program)对象时完成的)。为了展示这是这么工作的,我们会改变前面教程里的那个着色器,让顶点着色器为片段着色器决定颜色。

|

||||

|

||||

#### 顶点着色器

|

||||

|

||||

```c++

|

||||

#version 330 core

|

||||

layout (location = 0) in vec3 position; // 位置变量的属性为0

|

||||

|

||||

out vec4 vertexColor; // 为片段着色器指定一个颜色输出

|

||||

|

||||

void main()

|

||||

{

|

||||

gl_Position = vec4(position, 1.0); // 把一个vec3作为vec4的构造器的参数

|

||||

vertexColor = vec4(0.5f, 0.0f, 0.0f, 1.0f); // 把输出颜色设置为暗红色

|

||||

}

|

||||

```

|

||||

#### 片段着色器

|

||||

|

||||

```c++

|

||||

#version 330 core

|

||||

in vec4 vertexColor; // 和顶点着色器的vertexColor变量类型相同、名称相同

|

||||

|

||||

out vec4 color; // 片段着色器输出的变量名可以任意命名,类型必须是vec4

|

||||

|

||||

void main()

|

||||

{

|

||||

color = vertexColor;

|

||||

}

|

||||

```

|

||||

|

||||

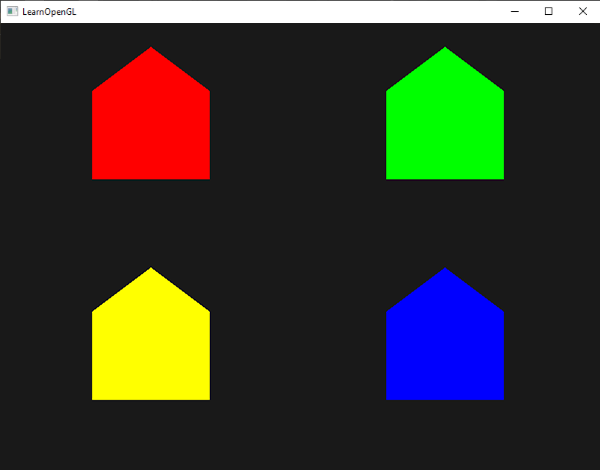

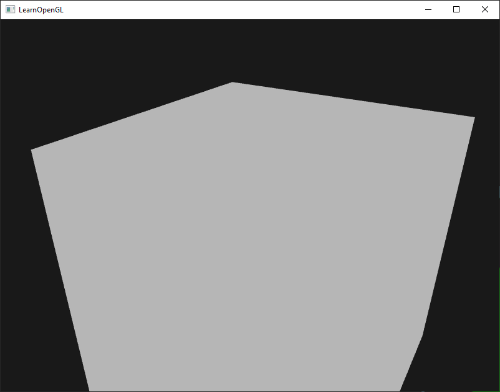

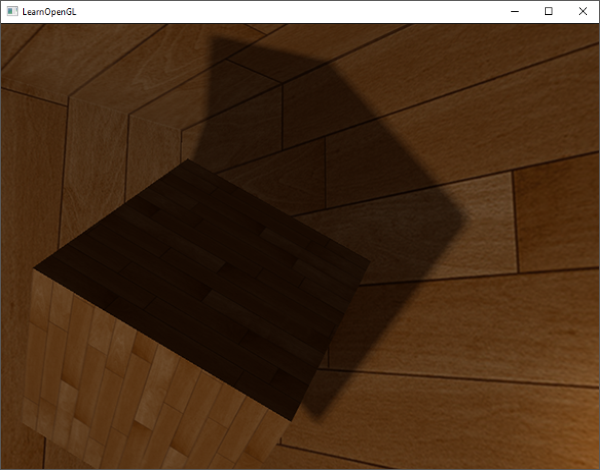

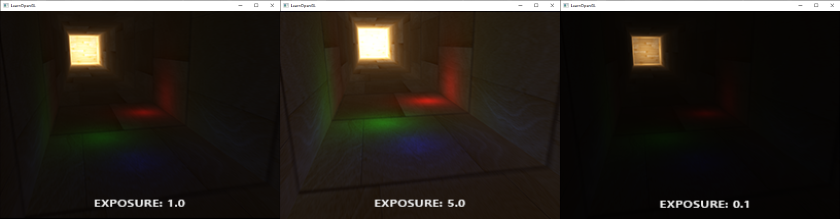

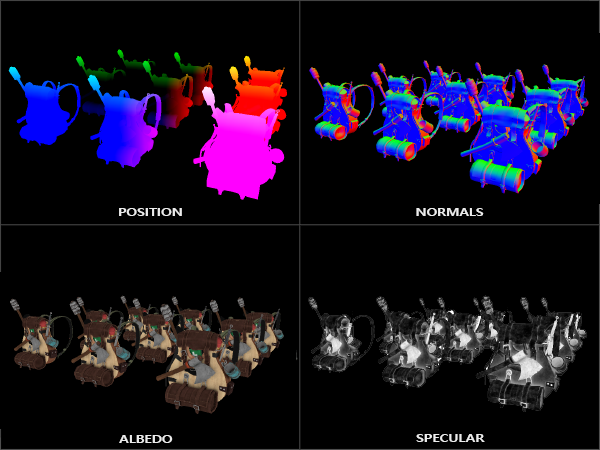

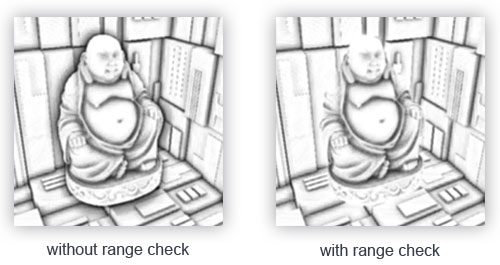

你可以看到我们在顶点着色器中声明了一个`vertexColor`变量作为`vec4`输出,在片段着色器声明了一个一样的`vertexColor`。由于它们**类型相同并且名字也相同**,片段着色器中的`vertexColor`就和顶点着色器中的`vertexColor`链接了。因为我们在顶点着色器中设置的颜色是深红色的,片段着色器输出的结果也是深红色的。下面的图片展示了输出结果:

|

||||

|

||||

|

||||

|

||||

我们完成了从顶点着色器向片段着色器发送数据。让我们更上一层楼,看看能否从应用程序中直接给片段着色器发送一个颜色!

|

||||

|

||||

## Uniform

|

||||

|

||||

uniform是另一种从CPU应用向GPU着色器发送数据的方式,但uniform和顶点属性有点不同。首先,uniform是**全局的(Global)**。这里全局的意思是uniform变量必须在所有着色器程序对象中都是独一无二的,它可以在着色器程序的任何着色器任何阶段使用。第二,无论你把uniform值设置成什么,uniform会一直保存它们的数据,直到它们被重置或更新。

|

||||

|

||||

我们可以简单地通过在片段着色器中设置uniform关键字接类型和变量名来声明一个GLSL的uniform。之后,我们可以在着色器中使用新声明的uniform了。我们来看看这次是否能通过uniform设置三角形的颜色:

|

||||

|

||||

```c++

|

||||

#version 330 core

|

||||

out vec4 color;

|

||||

|

||||

uniform vec4 ourColor; //在程序代码中设置

|

||||

|

||||

void main()

|

||||

{

|

||||

color = ourColor;

|

||||

}

|

||||

```

|

||||

|

||||

我们在片段着色器中声明了一个uniform vec4的`ourColor`,并把片段着色器的输出颜色设置为uniform值。因为uniform是全局变量,我们我们可以在任何着色器中定义它们,而无需通过顶点着色器作为中介。顶点着色器中不需要这个uniform所以不用在那里定义它。

|

||||

|

||||

!!! Attention

|

||||

|

||||

如果你声明了一个uniform却在GLSL代码中没用过,编译器会静默移除这个变量,从而最后编译出的版本中并不会包含它,如果有一个从没用过的uniform出现在已编译版本中会出现几个错误,记住这点!

|

||||

|

||||

uniform现在还是空的;我们没有给它添加任何数据,所以下面就做这件事。我们首先需要找到着色器中uniform的索引/地址。当我们得到uniform的索引/地址后,我们就可以更新它的值了。这里我们不去给像素传递一个颜色,而是随着时间让它改变颜色:

|

||||

|

||||

```c++

|

||||

GLfloat timeValue = glfwGetTime();

|

||||

GLfloat greenValue = (sin(timeValue) / 2) + 0.5;

|

||||

GLint vertexColorLocation = glGetUniformLocation(shaderProgram, "ourColor");

|

||||

glUseProgram(shaderProgram);

|

||||

glUniform4f(vertexColorLocation, 0.0f, greenValue, 0.0f, 1.0f);

|

||||

```

|

||||

|

||||

首先我们通过`glfwGetTime()`获取运行的秒数。然后我们使用余弦函数在0.0到-1.0之间改变颜色,最后储存到`greenValue`里。

|

||||

|

||||

接着,我们用`glGetUniformLocation`请求`uniform ourColor`的地址。我们为请求函数提供着色器程序和uniform的名字(这是我们希望获得的地址的来源)。如果`glGetUniformLocation`返回`-1`就代表没有找到这个地址。最后,我们可以通过`glUniform4f`函数设置uniform值。注意,查询uniform地址不需要在之前使用着色器程序,但是更新一个unform之前**必须**使用程序(调用`glUseProgram`),因为它是在当前激活的着色器程序中设置unform的。

|

||||

|

||||

!!! Important

|

||||

|

||||

因为OpenGL是C库内核,所以它不支持函数重载,在函数参数不同的时候就要定义新的函数;glUniform是一个典型例子。这个函数有一个特定的作为类型的后缀。有几种可用的后缀:

|

||||

|

||||

后缀|含义

|

||||

---|--

|

||||

f | 函数需要以一个float作为它的值

|

||||

i | 函数需要一个int作为它的值

|

||||

ui| 函数需要一个unsigned int作为它的值

|

||||

3f| 函数需要3个float作为它的值

|

||||

fv| 函数需要一个float向量/数组作为它的值

|

||||

|

||||

每当你打算配置一个OpenGL的选项时就可以简单地根据这些规则选择适合你的数据类型的重载的函数。在我们的例子里,我们使用uniform的4float版,所以我们通过`glUniform4f`传递我们的数据(注意,我们也可以使用fv版本)。

|

||||

|

||||

现在你知道如何设置uniform变量的值了,我们可以使用它们来渲染了。如果我们打算让颜色慢慢变化,我们就要在游戏循环的每一帧更新这个uniform,否则三角形就不会改变颜色。下面我们就计算greenValue然后每个渲染迭代都更新这个uniform:

|

||||

|

||||

```c++

|

||||

while(!glfwWindowShouldClose(window))

|

||||

{

|

||||

// 检测事件

|

||||

glfwPollEvents();

|

||||

|

||||

// 渲染

|

||||

// 清空颜色缓冲

|

||||

glClearColor(0.2f, 0.3f, 0.3f, 1.0f);

|

||||

glClear(GL_COLOR_BUFFER_BIT);

|

||||

|

||||

// 激活着色器

|

||||

glUseProgram(shaderProgram);

|

||||

|

||||

// 更新uniform颜色

|

||||

GLfloat timeValue = glfwGetTime();

|

||||

GLfloat greenValue = (sin(timeValue) / 2) + 0.5;

|

||||

GLint vertexColorLocation = glGetUniformLocation(shaderProgram, "ourColor");

|

||||

glUniform4f(vertexColorLocation, 0.0f, greenValue, 0.0f, 1.0f);

|

||||

|

||||

// 绘制三角形

|

||||

glBindVertexArray(VAO);

|

||||

glDrawArrays(GL_TRIANGLES, 0, 3);

|

||||

glBindVertexArray(0);

|

||||

}

|

||||

```

|

||||

|

||||

新代码和上一节的很相似。这次,我们在每个循环绘制三角形前先更新uniform值。如果你成功更新uniform了,你会看到你的三角形逐渐由绿变黑再变绿。

|

||||

|

||||

<video src="http://learnopengl.com/video/getting-started/shaders.mp4" controls="controls"/></video>

|

||||

|

||||

如果你在哪儿卡住了,[这里有源码](http://www.learnopengl.com/code_viewer.php?code=getting-started/shaders-uniform)。

|

||||

|

||||

就像你所看到的那样,uniform是个设置属性的很有用的工具,它可以在渲染循环中改变,也可以在你的应用和着色器之间进行数据交互,但假如我们打算为每个顶点设置一个颜色的时候该怎么办?这种情况下,我们就不得不声明和顶点数目一样多的uniform了。在顶点属性问题上一个更好的解决方案一定要能包含足够多的数据,这是我们接下来要讲的内容。

|

||||

|

||||

## 更多属性

|

||||

|

||||

前面的教程中,我们了解了如何填充VBO、配置顶点属性指针以及如何把它们都储存到VAO里。这次,我们同样打算把颜色数据加进顶点数据中。我们将把颜色数据表示为3个float的**顶点数组(Vertex Array)**。我们为三角形的每个角分别指定为红色、绿色和蓝色:

|

||||

|

||||

```c++

|

||||

GLfloat vertices[] = {

|

||||

// 位置 // 颜色

|

||||

0.5f, -0.5f, 0.0f, 1.0f, 0.0f, 0.0f, // 右下

|

||||

-0.5f, -0.5f, 0.0f, 0.0f, 1.0f, 0.0f, // 左下

|

||||

0.0f, 0.5f, 0.0f, 0.0f, 0.0f, 1.0f // 顶部

|

||||

};

|

||||

```

|

||||

|

||||

由于我们现在发送到顶点着色器的数据更多了,有必要调整顶点着色器,使它能够把颜色值作为一个顶点属性输入。需要注意的是我们用`layout`标识符来吧`color`属性的`location`设置为1:

|

||||

|

||||

```c++

|

||||

#version 330 core

|

||||

layout (location = 0) in vec3 position; // 位置变量的属性position为 0

|

||||

layout (location = 1) in vec3 color; // 颜色变量的属性position为 1

|

||||

|

||||

out vec3 ourColor; // 向片段着色器输出一个颜色

|

||||

|

||||

void main()

|

||||

{

|

||||

gl_Position = vec4(position, 1.0);

|

||||

ourColor = color; // 把ourColor设置为我们从顶点数据那里得到的输入颜色

|

||||

}

|

||||

```

|

||||

|

||||

由于我们不再使用uniform来传递片段的颜色了,现在使用的`ourColor`输出变量要求必须也去改变片段着色器:

|

||||

|

||||

```c++

|

||||

#version 330 core

|

||||

in vec3 ourColor

|

||||

out vec4 color;

|

||||

void main()

|

||||

{

|

||||

color = vec4(ourColor, 1.0f);

|

||||

}

|

||||

```

|

||||

|

||||

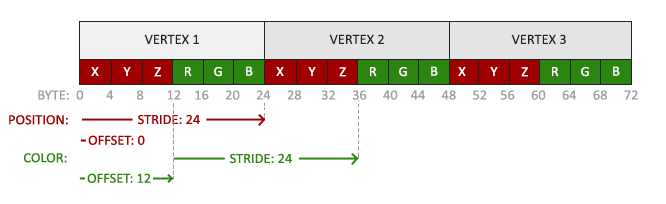

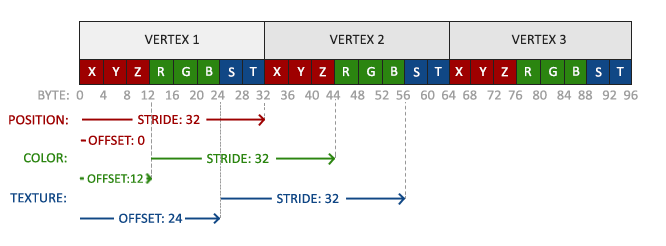

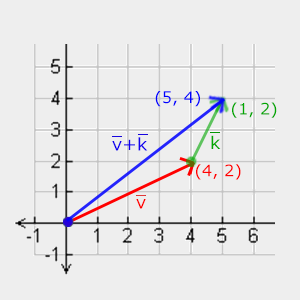

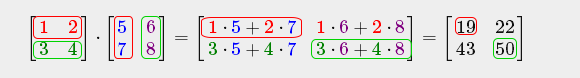

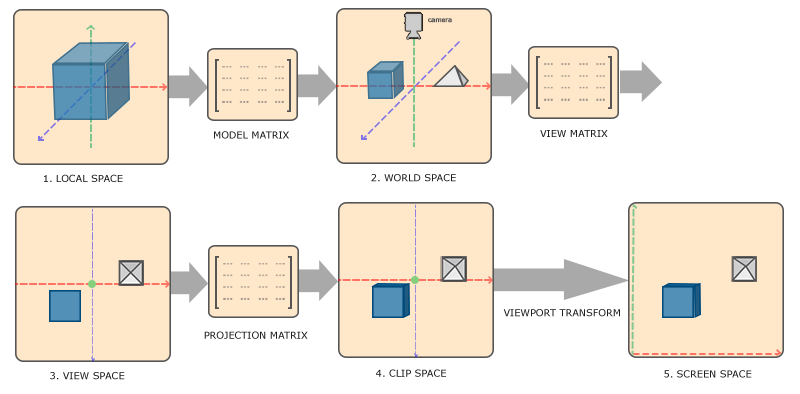

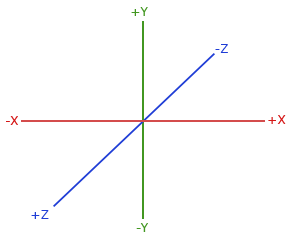

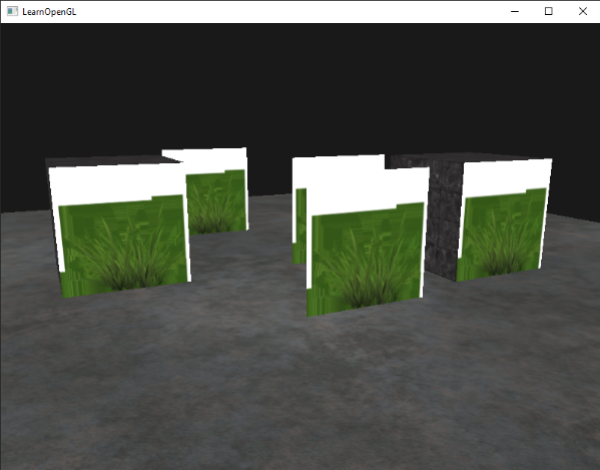

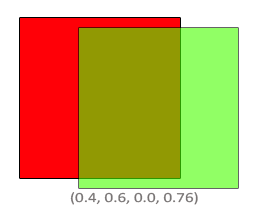

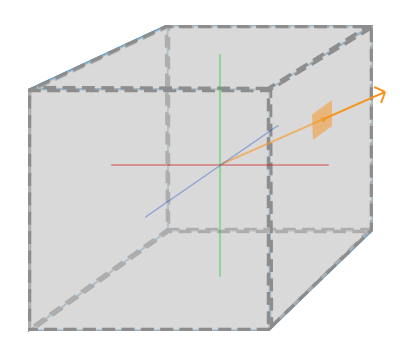

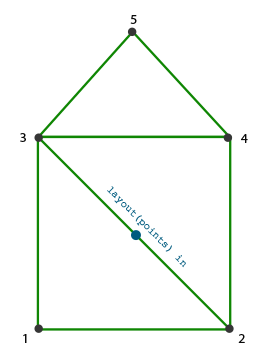

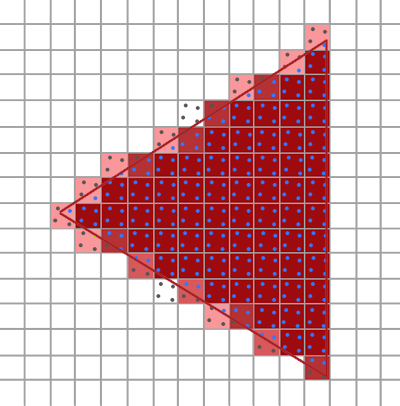

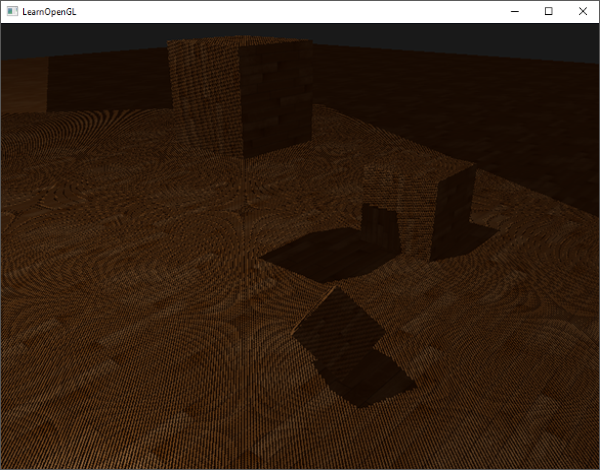

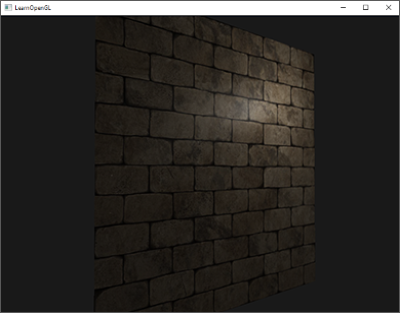

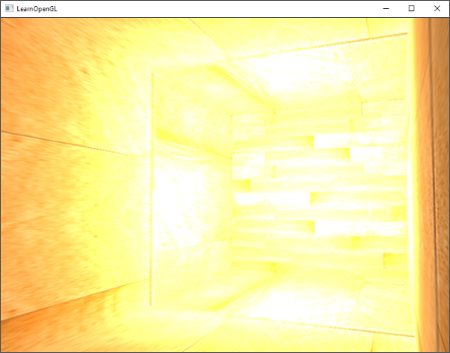

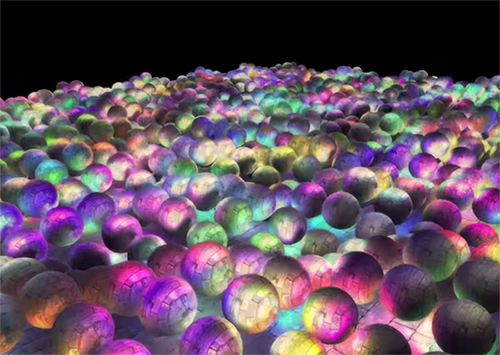

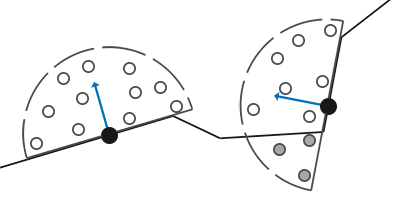

因为我们添加了另一个顶点属性,并且更新了VBO的内存,我们就必须重新配置顶点属性指针。更新后的VBO内存中的数据现在看起来像这样:

|

||||

|

||||

|

||||

|

||||

知道了当前使用的layout,我们就可以使用`glVertexAttribPointer`函数更新顶点格式,

|

||||

|

||||

```c++

|

||||

// 顶点属性

|

||||

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 6 * sizeof(GLfloat), (GLvoid*)0);

|

||||

glEnableVertexAttribArray(0);

|

||||

// 颜色属性

|

||||

glVertexAttribPointer(1, 3, GL_FLOAT, GL_FALSE, 6 * sizeof(GLfloat), (GLvoid*)(3* sizeof(GLfloat)));

|

||||

glEnableVertexAttribArray(1);

|

||||

```

|

||||

|

||||

`glVertexAttribPointer`函数的前几个参数比较明了。这次我们配置属性location为1的顶点属性。颜色值有3个float那么大,我们不去标准化这些值。

|

||||

|

||||

由于我们现在有了两个顶点属性,我们不得不重新计算步长值(Stride)。为获得数据队列中下一个属性值(比如位置向量的下个x元素)我们必须向右移动6个float,其中3个是位置值,另外三个是颜色值。这给了我们6个步长的大小,每个步长都是float的字节数(=24字节)。

|

||||

|

||||

同样,这次我们必须指定一个偏移量(Offset)。对于每个顶点来说,位置(Position)顶点属性是先声明的,所以它的偏移量是0。颜色属性紧随位置数据之后,所以偏移量就是`3*sizeof(GLfloat)`,用字节来计算就是12字节。

|

||||

|

||||

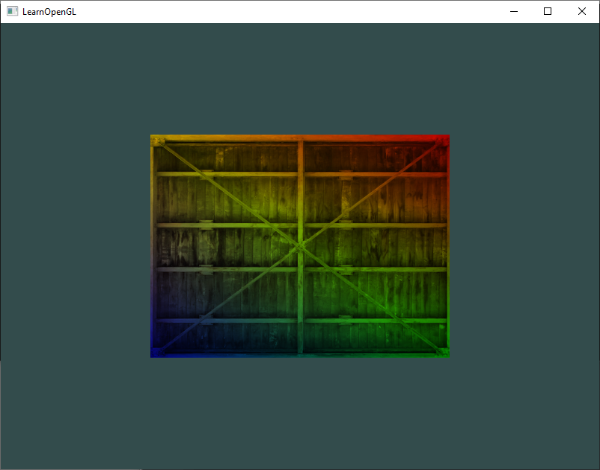

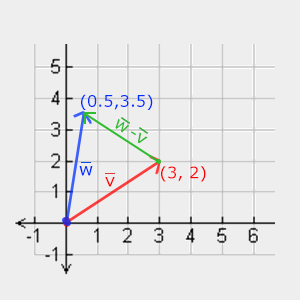

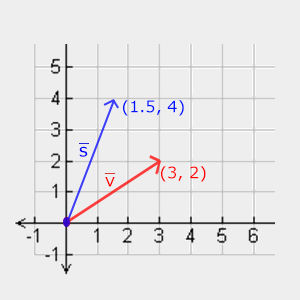

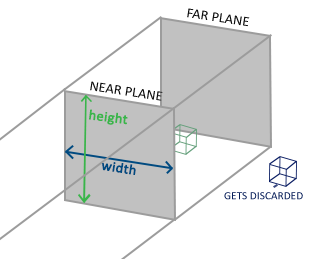

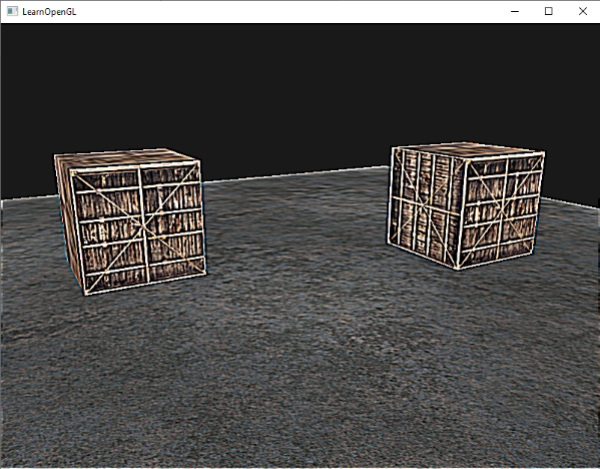

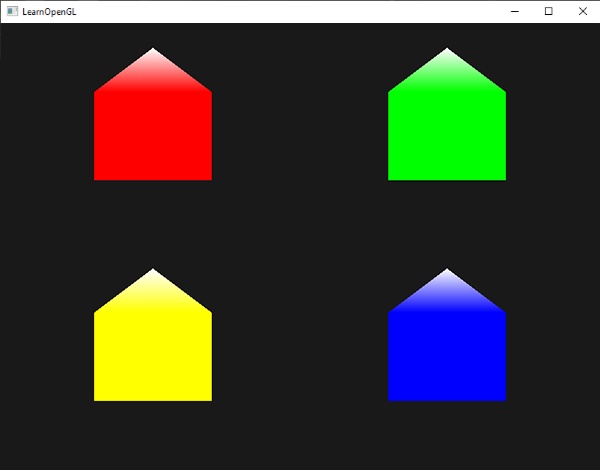

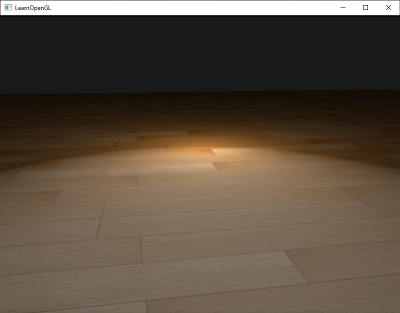

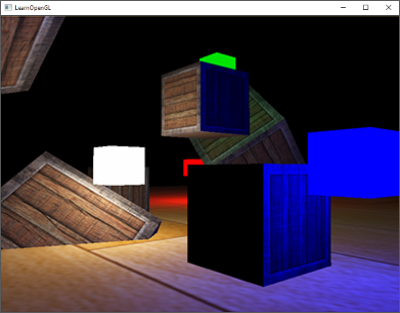

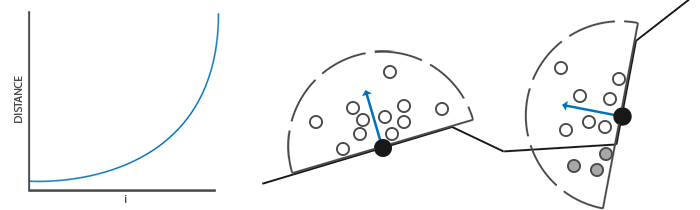

运行应用你会看到如下结果:

|

||||

|

||||

|

||||

如果你有困惑,可以[在这里获得源码](http://learnopengl.com/code_viewer.php?code=getting-started/shaders-interpolated)。

|

||||

|

||||

这个图片可能不是你所期望的那种,因为我们只提供3个颜色,而不是我们现在看到的大调色板。这是所谓片段着色器进行**片段插值(Fragment Interpolation)**的结果。当渲染一个三角形在像素化(Rasterization 也译为光栅化)阶段通常生成比原来的顶点更多的像素。像素器就会基于每个像素在三角形的所处相对位置决定像素的位置。

|

||||

|

||||

基于这些位置,它**插入(Interpolate)**所有片段着色器的输入变量。比如说,我们有一个线段,上面的那个点是绿色的,下面的点是蓝色的。如果一个片段着色器正在处理的那个片段(实际上就是像素)是在线段的70%的位置,它的颜色输入属性就会是一个绿色和蓝色的线性结合;更精确地说就是30%蓝+70%绿。

|

||||

|

||||

这正是这个三角形里发生的事。我们有3个顶点,和相应的3个颜色,从这个三角形的像素来看它可能包含50,000左右的像素,片段着色器为这些像素进行插值。如果你仔细看这些颜色,你会发现其中的奥秘:红到紫再到蓝。像素插值会应用到所有片段着色器的输入属性上。

|

||||

|

||||

## 我们自己的着色器类

|

||||

|

||||

编写、编译、管理着色器是件麻烦事。在着色器的最后主题里,我们会写一个类来让我们的生活轻松一点,这个类从硬盘读着色器,然后编译和链接它们,对它们进行错误检测,这就变得很好用了。这也会给你一些关于如何把我们目前所学的知识封装到一个抽象的对象里的灵感。

|

||||

|

||||

我们会在头文件里创建整个类,主要为了学习,也可以方便移植。我们先来添加必要的include,定义类结构:

|

||||

|

||||

```c++

|

||||

#ifndef SHADER_H

|

||||

#define SHADER_H

|

||||

|

||||

#include <string>

|

||||

#include <fstream>

|

||||

#include <sstream>

|

||||

#include <iostream>

|

||||

|

||||

using namespace std;

|

||||

|

||||

#include <GL/glew.h>; // 包含glew获取所有的OpenGL必要headers

|

||||

|

||||

class Shader

|

||||

{

|

||||

public:

|

||||

// 程序ID

|

||||

GLuint Program;

|

||||

// 构造器读取并创建Shader

|

||||

Shader(const GLchar * vertexSourcePath, const GLchar * fragmentSourcePath);

|

||||

// 使用Program

|

||||

void Use();

|

||||

};

|

||||

|

||||

#endif

|

||||

```

|

||||

|

||||

!!! Important

|

||||

|

||||

在上面,我们用了几个预处理指令(Preprocessor Directives)。这些预处理指令告知你的编译器,只在没被包含过的情况下才包含和编译这个头文件,即使多个文件都包含了这个shader头文件,它是用来防止链接冲突的。

|

||||

|

||||

shader类保留了着色器程序的ID。它的构造器需要顶点和片段着色器源代码的文件路径,我们可以把各自的文本文件储存在硬盘上。`Use`函数看似平常,但是能够显示这个自造类如何让我们的生活变轻松(虽然只有一点)。

|

||||

|

||||

### 从文件读取

|

||||

|

||||

我们使用C++文件流读取着色器内容,储存到几个string对象里([译注1])

|

||||

|

||||

```c++

|

||||

Shader(const GLchar * vertexPath, const GLchar * fragmentPath)

|

||||

{

|

||||

// 1. 从文件路径获得vertex/fragment源码

|

||||

std::string vertexCode;

|

||||

std::string fragmentCode;

|

||||

|

||||

try {

|

||||

// 打开文件

|

||||

std::ifstream vShaderFile(vertexPath);

|

||||

std::ifstream fShaderFile(fragmentPath);

|

||||

|

||||

std::stringstream vShaderStream, fShaderStream;

|

||||

// 读取文件缓冲到流

|

||||

vShaderStream << vShaderFile.rdbuf();

|

||||

fShaderStream << fShaderFile.rdbuf();

|

||||

|

||||

// 关闭文件句柄

|

||||

vShaderFile.close();

|

||||

fShaderFile.close();

|

||||

|

||||

// 将流转为GLchar数组

|

||||

vertexCode = vShaderStream.str();

|

||||

fragmentCode = fShaderStream.str();

|

||||

}

|

||||

catch(std::exception e)

|

||||

{

|

||||

std::cout << "ERROR::SHADER::FILE_NOT_SUCCESFULLY_READ" << std::endl;

|

||||

}

|

||||

```

|

||||

|

||||

下一步,我们需要编译和链接着色器。注意,我们也要检查编译/链接是否失败,如果失败,打印编译错误,调试的时候这及其重要(这些错误日志你总会需要的):

|

||||

|

||||

```c++

|

||||

// 2. 编译着色器

|

||||

GLuint vertex, fragment;

|

||||

GLint success;

|

||||

GLchar infoLog[512];

|

||||

|

||||

// 顶点着色器

|

||||

vertex = glCreateShader(GL_VERTEX_SHADER);

|

||||

glShaderSource(vertex, 1, &vShaderCode, NULL);

|

||||

glCompileShader(vertex);

|

||||

|

||||

// 打印编译时错误

|

||||

glGetShaderiv(vertex, GL_COMPILE_STATUS, &success);

|

||||

if(!success)

|

||||

{

|

||||

glGetShaderInfoLog(vertex, 512, NULL, infoLog);

|

||||

std::cout << "ERROR::SHADER::VERTEX::COMPILATION_FAILED\n" << infoLog << std::endl;

|

||||